AI 추론이 점점 더 중요해지고 있습니다. 특히 대규모 GPU 환경에서 효율적인 추론 처리는 AI 모델의 성능뿐만 아니라 운영 비용과 수익성에도 큰 영향을 미칩니다. NVIDIA는 이러한 요구를 해결하기 위해 **AI 팩토리의 비용을 절감하고 성능을 극대화할 수 있는 오픈소스 추론 소프트웨어 ‘NVIDIA Dynamo’**를 발표했습니다.

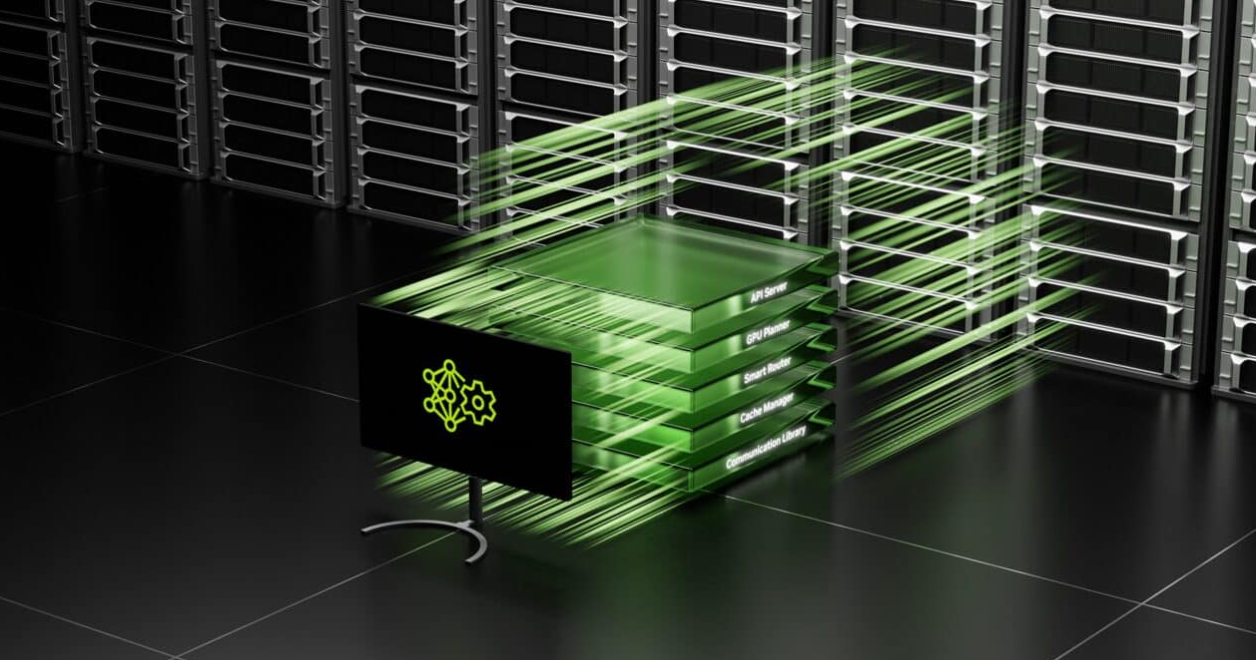

Dynamo는 대규모 AI 모델의 추론을 최적화하고, GPU 리소스를 효과적으로 활용하며, 운영 효율을 극대화하는 AI 추론 서빙 소프트웨어입니다. NVIDIA Blackwell 아키텍처와 결합하여 딥시크(DeepSeek)-R1 모델의 처리량을 30배 이상 증가시키며, AI 모델이 보다 빠르고 효율적으로 추론할 수 있도록 지원합니다.

이 블로그에서는 NVIDIA Dynamo의 주요 기능과 특징, AI 모델 최적화 방식, 그리고 실제 활용 사례까지 자세히 살펴보겠습니다.

1. NVIDIA Dynamo란?

NVIDIA Dynamo는 대규모 AI 추론을 최적화하기 위한 오픈소스 AI 서빙 솔루션입니다. 기존의 **NVIDIA Triton Inference Server™**를 발전시킨 형태로, 특히 거대 언어 모델(LLM)과 같은 복잡한 AI 추론을 보다 효율적으로 처리할 수 있도록 설계되었습니다.

💡 주요 특징

✅ 대규모 GPU 환경에서 AI 추론 성능 최적화

✅ 추론 비용 절감 및 처리 속도 향상

✅ 분리 서빙(Decoupled Serving) 방식으로 GPU 활용 극대화

✅ 오픈소스로 제공, 다양한 AI 프레임워크(Pytorch, TensorRT, vLLM 등) 지원

Dynamo는 기존과 같은 GPU 수를 사용하면서도 AI 팩토리의 성능과 수익을 2배 이상 증가시킬 수 있습니다.

2. NVIDIA Dynamo의 핵심 기술

🔹 분리 서빙(Decoupled Serving) 기술

대규모 AI 추론은 모델의 여러 단계를 동시에 수행해야 하므로 많은 계산 리소스를 요구합니다. NVIDIA Dynamo는 이를 해결하기 위해 분리 서빙 방식을 도입하여, 모델의 각 단계를 서로 다른 GPU에 분리 배치할 수 있도록 합니다.

✅ LLM의 다양한 연산 단계를 개별 GPU에 배분

✅ 각 단계별 최적화로 성능 향상 및 응답 속도 개선

✅ 메모리 및 계산 리소스를 효율적으로 활용

이 방식을 통해 특정 단계에서 병목이 발생하는 문제를 최소화하고, GPU 활용도를 극대화할 수 있습니다.

🔹 GPU 자원 최적화 및 자동 스케일링

NVIDIA Dynamo는 AI 모델 추론을 실행하는 GPU를 자동으로 추가하거나 제거하여 가변적인 요청 수요에 대응할 수 있습니다.

✅ GPU 플래너(GPU Planner): AI 요청에 맞춰 GPU를 동적으로 할당 및 해제

✅ 스마트 라우터(Smart Router): 가장 적합한 GPU에 요청을 분산하여 연산 속도 향상

✅ 메모리 매니저(Memory Manager): 데이터 오프로드 및 로딩을 최적화하여 비용 절감

이러한 최적화 기능을 통해 불필요한 리소스 낭비를 방지하고, 추론 성능을 극대화할 수 있습니다.

🔹 GPU 간 저지연(로우 레이턴시) 통신

AI 추론에서는 GPU 간 데이터 교환 속도가 중요한 요소입니다. NVIDIA Dynamo는 고속 GPU-to-GPU 통신을 지원하는 라이브러리를 포함하고 있어 데이터 전송 속도를 향상시킵니다.

✅ 이종(Heterogeneous) GPU 간 빠른 데이터 교환 지원

✅ 추론 컨텍스트를 효과적으로 공유하여 중복 연산 최소화

이 기능을 활용하면 대규모 AI 모델이 보다 빠르게 추론을 수행할 수 있으며, GPU 클러스터 전체에서 효율적인 작업 배분이 가능합니다.

3. NVIDIA Dynamo 활용 사례

🔹 AI 검색 및 추천 시스템 (퍼플렉시티 AI)

AI 검색 엔진 퍼플렉시티(Perplexity)는 매월 수억 건의 AI 기반 검색 요청을 처리해야 합니다. NVIDIA Dynamo를 활용하면 대량의 AI 추론을 빠르고 비용 효율적으로 실행할 수 있습니다.

✅ AI 검색 요청을 최적의 GPU에 라우팅하여 응답 시간 단축

✅ 지능형 추론 최적화로 동일한 GPU에서도 처리량 증가

🔹 에이전틱 AI(Agentic AI) 모델 (Cohere)

AI 스타트업 Cohere는 NVIDIA Dynamo를 활용해 자사 AI 모델인 'Command'의 에이전틱 AI 기능을 강화하고 있습니다.

✅ GPU 스케줄링을 최적화하여 모델 확장성 향상

✅ 메모리와 스토리지 전반에서 AI 추론 컨텍스트 전송 속도 개선

🔹 AI 클라우드 서비스 (Together AI)

AI 가속 클라우드 플랫폼 Together AI는 NVIDIA Dynamo를 자체 인퍼런스 엔진과 통합하여, 대규모 GPU 클러스터에서 AI 추론 워크로드를 최적화하고 있습니다.

✅ AI 추론 성능을 극대화하면서도 비용 효율적인 모델 제공

✅ 클라우드 기반 AI 서비스의 확장성과 운영 효율성 향상

4. NVIDIA Dynamo의 미래와 기대 효과

NVIDIA Dynamo는 AI 추론을 보다 효율적이고 경제적으로 수행할 수 있도록 지원하는 강력한 오픈소스 솔루션입니다. 이를 통해 AI 팩토리는 다음과 같은 효과를 기대할 수 있습니다.

✅ AI 모델의 추론 성능 극대화 (30배 이상 향상 가능)

✅ 대규모 GPU 환경에서 리소스를 최적화하여 운영 비용 절감

✅ AI 서비스 제공업체의 수익 창출 기회 확대

✅ 오픈소스 생태계를 통해 AI 추론 기술 발전 가속화

NVIDIA Dynamo는 현재 PyTorch, TensorRT-LLM, vLLM 등 다양한 프레임워크와 호환되며, AI 기업뿐만 아니라 스타트업 및 연구자들에게도 새로운 AI 추론 최적화 방안을 제공할 것입니다.

👉 NVIDIA GTC 키노트에서 Dynamo에 대한 자세한 내용을 확인하세요!

AI 추론은 AI 서비스의 성능과 비용을 좌우하는 중요한 요소입니다. NVIDIA Dynamo는 대규모 GPU 환경에서 AI 모델의 추론을 최적화하고, 운영 비용을 절감하며, AI 팩토리의 수익을 극대화할 수 있도록 지원하는 혁신적인 오픈소스 솔루션입니다.

향후 NVIDIA Dynamo의 지속적인 발전을 통해 더 빠르고 효율적인 AI 추론 환경이 구축될 것으로 기대됩니다. 🚀

AI 추론 모델의 효율 극대화하는 오픈소스 라이브러리 ‘NVIDIA Dynamo’ - NVIDIA Blog Korea

AI 팩토리에서 AI 추론 모델을 최저 비용, 최고 효율로 가속하고 확장할 수 있는 오픈소스 추론 소프트웨어인 NVIDIA Dynamo를 공개합니다.

blogs.nvidia.co.kr

GitHub - ai-dynamo/dynamo: A Datacenter Scale Distributed Inference Serving Framework

A Datacenter Scale Distributed Inference Serving Framework - ai-dynamo/dynamo

github.com

'인공지능' 카테고리의 다른 글

| [GTC 2025] 내 책상 위의 AI 슈퍼컴퓨터! 엔비디아 DGX 스파크 & DGX 스테이션 출시 (0) | 2025.03.21 |

|---|---|

| AI 코딩 중 발견한 LLM의 맹점들: Claude Sonnet 기준 (0) | 2025.03.21 |

| GTC 2025: 젠슨 황 키노트 요약 – AI 추론의 새로운 시대 (0) | 2025.03.20 |

| [GTC 2025] NVIDIA의 에이전틱 AI 플랫폼 공개 – 차세대 AI 혁신을 이끄는 핵심 기술 (0) | 2025.03.20 |

| RTX 4090에서도 실행 가능! 미스트랄 AI의 강력한 소형 멀티모달 모델 'Mistral Small 3.1' 공개 (0) | 2025.03.19 |