AI 애플리케이션을 개발할 때 중요한 요소 중 하나는 텍스트를 얼마나 잘 이해하고 의미를 벡터로 표현할 수 있는가입니다. 특히 RAG(Retrieval-Augmented Generation)나 시맨틱 검색과 같은 기술에서는 임베딩 품질이 답변의 정확성을 결정짓습니다.

구글 딥마인드가 발표한 EmbeddingGemma는 이러한 문제를 해결하기 위해 개발된 최신 오픈 임베딩 모델입니다. 3억 800만 파라미터라는 초경량 구조임에도 불구하고 기존 두 배 크기의 모델과 견줄 만한 성능을 보여줍니다. 무엇보다 온디바이스 실행에 최적화되어 있어 인터넷 연결이 없어도 빠르고 안전하게 작동합니다.

이번 글에서는 EmbeddingGemma의 특징, 기술적 장점, 활용 사례를 살펴보고 개발자가 어떻게 적용할 수 있는지 정리해 보겠습니다.

1. EmbeddingGemma란 무엇인가

EmbeddingGemma는 문장이나 문서와 같은 텍스트를 고차원 벡터로 변환하는 임베딩 모델입니다.

- 의미 보존: 단순 단어 나열이 아닌 문맥과 의미를 수치 벡터로 표현

- 다국어 지원: 100개 이상의 언어 처리 가능

- 초경량 구조: 모바일, 노트북, 데스크톱 등 다양한 환경에서 실행 가능

즉, 복잡한 서버 인프라 없이도 로컬 기기에서 안정적으로 AI 기능을 구현할 수 있도록 설계되었습니다.

2. 주요 특징과 장점

최고 수준의 성능

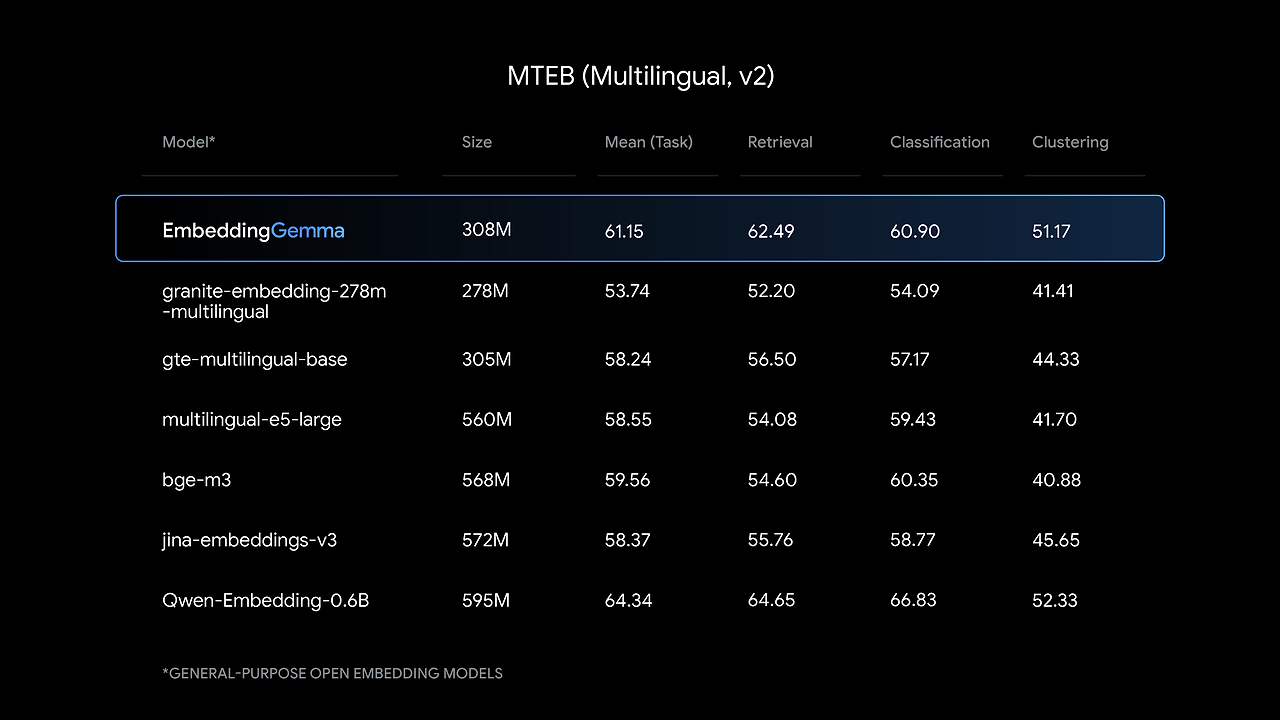

- Massive Text Embedding Benchmark(MTEB)에서 500M 미만 모델 중 가장 높은 성능 기록

- 다국어 임베딩 성능이 뛰어나 다양한 글로벌 서비스에 적합

- 작은 모델 크기에도 불구하고 두 배 크기의 모델과 유사한 품질 제공

초경량·고속 구조

- 총 3억 800만 파라미터 (모델 1억, 임베딩 2억)

- Matryoshka Representation Learning(MRL) 적용으로 768차원부터 128차원까지 유연하게 선택 가능

- EdgeTPU 환경에서 256 토큰 기준 15ms 이내 응답 속도 제공

오프라인 실행 지원

- 양자화 적용으로 메모리 사용량을 200MB 이하로 줄임

- 인터넷 연결 없이 기기 내부에서 데이터 처리 가능해 개인정보 보호에 유리

- Gemma 3n과 호환되어 모바일 RAG 파이프라인이나 시맨틱 검색 구현 가능

통합 생태계 지원

- sentence-transformers, llama.cpp, MLX, Ollama, LiteRT, transformers.js, LangChain, LlamaIndex, Weaviate 등과 즉시 호환

3. EmbeddingGemma 활용 사례

개인 데이터 검색

인터넷 연결 없이도 이메일, 알림, 텍스트, 파일 등 개인 데이터를 한 번에 검색할 수 있습니다.

개인화된 오프라인 챗봇

Gemma 3n과 결합하면 개인 맞춤형 오프라인 챗봇을 구현할 수 있습니다.

실시간 모바일 AI 에이전트

사용자 요청을 임베딩하고 가장 적절한 함수나 문서를 연결해 지연 없는 실시간 응답이 가능합니다.

파인튜닝 확장성

특정 도메인이나 언어에 맞춰 모델을 파인튜닝하여 다양한 업무에 적용할 수 있습니다.

4. 간단한 사용 예시: RAG 파이프라인

EmbeddingGemma는 RAG 파이프라인에서 특히 강력합니다.

- 사용자 쿼리 임베딩 생성

from sentence_transformers import SentenceTransformer

model = SentenceTransformer("google/embedding-gemma")

query_embedding = model.encode("내 목재 바닥 수리 업체 연락처 알려줘")

- 문서 임베딩과 유사도 비교

from sklearn.metrics.pairwise import cosine_similarity

similarities = cosine_similarity([query_embedding], document_embeddings)

top_doc = documents[similarities.argmax()]

- 관련 문서와 원 쿼리를 생성 모델에 전달

→ Gemma 3 같은 생성 모델과 결합해 문맥에 맞는 답변을 생성

EmbeddingGemma는 가볍지만 강력한 온디바이스 AI 모델의 새로운 가능성을 보여줍니다.

- 대규모 서버 없이도 고품질 임베딩 활용 가능

- 모바일과 개인 기기에서 개인화된 AI 경험 제공

- 다양한 생태계와의 호환성을 통해 빠르게 프로젝트에 적용 가능

앞으로 EmbeddingGemma는 프라이버시 중심 검색, 오프라인 챗봇, 실시간 AI 서비스 등 다양한 분야에서 핵심 역할을 할 것으로 기대됩니다.

현재 Hugging Face, Kaggle, Vertex AI에서 모델을 다운로드할 수 있으며, 제공되는 문서와 예제를 통해 빠르게 프로젝트에 적용할 수 있습니다.

Introducing EmbeddingGemma: The Best-in-Class Open Model for On-Device Embeddings- Google Developers Blog

We're excited to introduce EmbeddingGemma, a new open embedding model that delivers best-in-class performance for its size. Designed specifically for on-device AI, its highly efficient 308 million parameter design enables you to build applications using te

developers.googleblog.com

'인공지능' 카테고리의 다른 글

| FineVision: 멀티모달 AI의 판을 바꾸는 초대형 데이터셋 공개 (0) | 2025.09.05 |

|---|---|

| Zed에서 Claude Code 활용하기: ACP 기반 차세대 개발 환경의 시작 (0) | 2025.09.05 |

| 데이터 과학의 미래, Databricks Assistant Data Science Agent로 몇 시간의 일을 단 몇 분 만에 (0) | 2025.09.05 |

| 마더 프로토콜: 제프리 힌튼 박사가 말하는 초지능 AI와 인간 공존의 길 (0) | 2025.09.04 |

| 개발자의 흐름을 지켜주는 새로운 패러다임, Vibe Ops란 무엇인가? (0) | 2025.09.04 |