알리바바 Qwen 팀이 새로운 언어 모델 Qwen3-Next-80B-A3B의 FP8 양자화 버전을 공개했습니다. 이번 모델은 Instruct와 Thinking 두 가지 형태로 제공되며, 초장문 컨텍스트 지원과 Mixture-of-Experts(MoE) 효율성을 극대화해 고속 추론과 메모리 효율성을 동시에 달성하는 것을 목표로 하고 있습니다.

이번 릴리스는 단순히 모델 크기를 키운 것이 아니라, 하이브리드 아키텍처와 FP8 최적화를 통해 대규모 AI 모델을 더 실용적으로 운영할 수 있는 방법을 제시합니다. 이 글에서는 Qwen3-Next-80B-A3B의 아키텍처 특징, FP8 릴리스의 의미, 성능 결과, 그리고 실질적인 활용 가능성을 살펴보겠습니다.

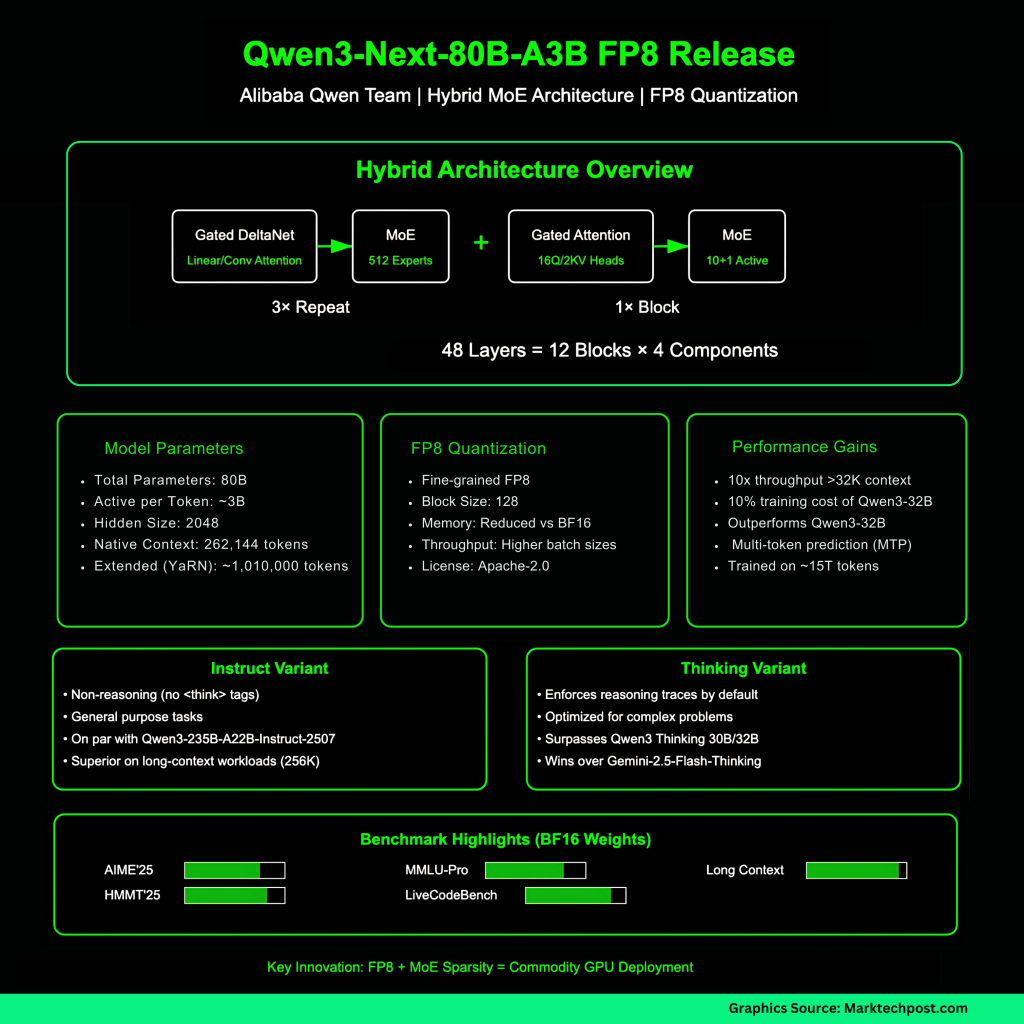

Qwen3-Next-80B-A3B 아키텍처의 특징

1. 하이브리드 구조 설계

Qwen3-Next-80B-A3B는 단순한 트랜스포머 아키텍처가 아닙니다. Gated DeltaNet과 Gated Attention을 교차적으로 배치하고, 여기에 **초희소 MoE(Mixture-of-Experts)**를 결합한 하이브리드 형태입니다.

- 총 파라미터 수: 800억(80B)

- 활성화되는 파라미터: 토큰당 약 30억(3B)

- 전문가 수: 512개 전문가 중 10개 라우팅 + 1개 공유 전문가

- 구조 배치: 48개 레이어를 12개 블록으로 구성 (3개의 DeltaNet → MoE, 1개의 Attention → MoE 반복)

이 설계 덕분에 모델은 거대한 규모에도 불구하고, 실제 추론 시에는 일부 전문가만 선택적으로 활성화해 계산량과 비용을 줄이면서 성능을 유지할 수 있습니다.

2. 초장문 컨텍스트 지원 능력

Qwen3-Next-80B-A3B는 긴 문맥 처리에 최적화되어 있습니다.

- 기본 컨텍스트 길이: 262,144 토큰

- RoPE 스케일링(YaRN) 검증: 최대 약 1,010,000 토큰까지 확장 가능

이는 수십만 단어에 이르는 법률 문서, 수천 줄 이상의 코드, 방대한 연구 논문과 같은 초장문 데이터 분석 및 생성에 강력한 성능을 제공합니다.

3. 효율성과 성능

Qwen 팀은 본 모델이 Qwen3-32B 대비 학습 비용은 10% 수준에 불과하지만, 성능은 동급 이상을 달성했다고 밝혔습니다.

또한 초장문 컨텍스트(32K 이상) 환경에서 추론 속도가 약 10배 이상 향상되었습니다.

이 성능 향상의 배경에는 두 가지 요소가 있습니다.

- MoE의 낮은 활성화 비율 → 불필요한 계산 최소화

- MTP(Multi-Token Prediction) → 여러 토큰을 동시에 예측하여 추론 속도를 가속화

FP8 릴리스: 무엇이 달라졌나

1. FP8 양자화 방식

이번 릴리스의 가장 큰 변화는 세밀한(fine-grained) FP8 양자화입니다.

- 블록 크기: 128

- 효과:

- 메모리 대역폭 소모 감소

- 더 큰 배치 사이즈 지원

- 더 긴 시퀀스 처리 가능

- BF16 대비 낮은 지연(latency) 유지

이는 특히 대규모 모델을 상용 환경에서 운영할 때 중요한 의미를 갖습니다. 동일한 하드웨어에서 더 많은 데이터와 더 긴 입력을 처리할 수 있기 때문입니다.

2. 배포 환경과 실행 옵션

FP8 버전은 기존 BF16 모델과 달리 최신 nightly 빌드의 sglang 및 vLLM 엔진에서 실행해야 합니다.

- 256K 컨텍스트 실행 예시가 함께 제공되어 있어, 실제 배포 시 바로 적용할 수 있습니다.

- Thinking 버전의 경우 복잡한 문제 해결에 최적화되어 있으며, 실행 시 --reasoning-parser 옵션을 추가해 추론 흔적(reasoning traces)을 활성화하는 것을 권장합니다.

3. Instruct vs Thinking 변형

- Instruct 모델:

- 일반적인 지시 기반 작업 수행에 최적화

- 태그 없는 비추론형 모델

- Thinking 모델:

- 복잡한 수학적, 논리적 문제 해결에 최적화

- 추론 과정을 기록하여 더 정교한 답변 생성 가능

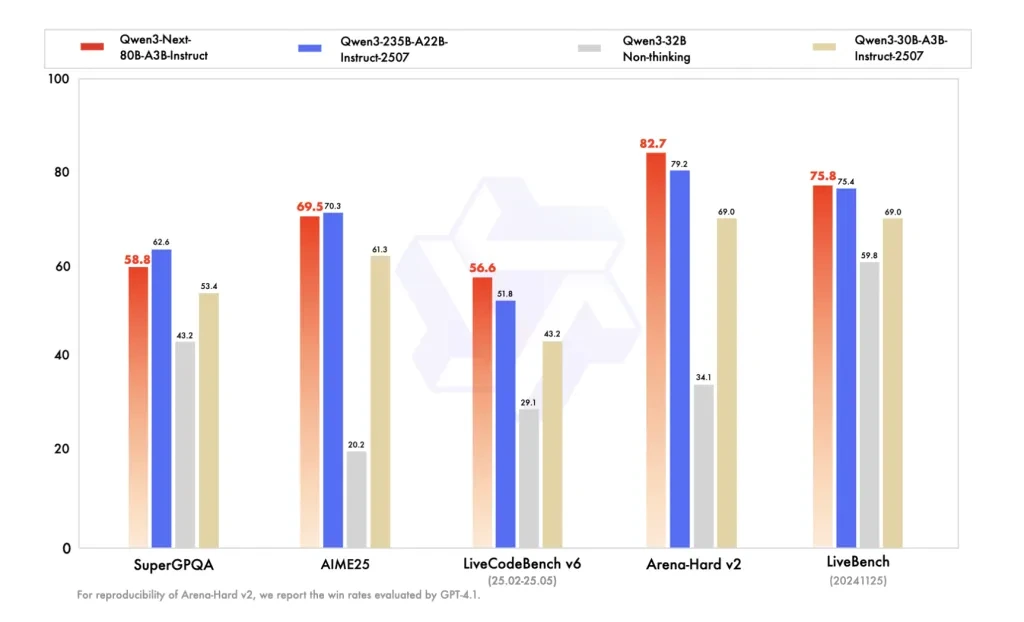

벤치마크 성능

FP8 릴리스는 기존 BF16 모델의 벤치마크 결과를 그대로 유지합니다.

- Instruct 모델 성능:

- Qwen3-235B-Instruct와 동급

- 초장문 컨텍스트(256K) 작업에서는 더 우수한 성능

- Thinking 모델 성능:

- AIME’25, HMMT’25, MMLU-Pro/Redux, LiveCodeBench v6 등 최신 벤치마크에서 이전 Qwen 모델(30B, 32B)보다 뛰어난 결과

- Gemini-2.5-Flash-Thinking과 비교해 일부 벤치마크에서 우위

즉, FP8 양자화에도 불구하고 기존 모델의 성능은 그대로 유지되며, 오히려 추론 속도와 메모리 효율성은 크게 개선됩니다.

FP8이 가지는 의미

FP8은 단순히 숫자 정밀도를 낮추는 것이 아닙니다. 최신 AI 가속기 환경에서 FP8은 실용적 장점을 제공합니다.

- 메모리 절감: BF16 대비 훨씬 작은 메모리 공간을 차지하여 대규모 모델도 일반 GPU에서 실행 가능

- 처리량 증가: 동일한 자원으로 더 많은 데이터를 병렬 처리 가능

- 긴 컨텍스트 최적화: 초장문 입력에서도 안정적인 추론 가능

- MoE와의 시너지: 토큰당 30억 파라미터만 활성화되는 구조와 FP8 양자화가 결합해 현실적인 비용으로 대규모 모델 활용 가능

다만 FP8은 정밀도가 낮기 때문에, 특정 작업에서는 추론 정확도나 수렴 속도에 영향을 줄 수 있습니다. 따라서 Qwen 팀은 실제 환경에 맞춘 벤치마크와 튜닝을 권장하고 있습니다.

알리바바 Qwen 팀의 Qwen3-Next-80B-A3B FP8 릴리스는 초장문 컨텍스트와 고속 추론을 동시에 지원하는 새로운 방향을 보여주고 있습니다.

- 효율성: FP8 양자화와 MoE 구조로 메모리와 계산 자원 절감

- 실용성: 256K 이상의 초장문 입력도 실질적으로 처리 가능

- 확장성: Instruct와 Thinking 모델을 통해 다양한 활용 시나리오 대응

이 모델은 법률, 금융, 연구, 소프트웨어 개발 등 대규모 데이터와 긴 문맥 처리가 필수적인 산업 분야에서 즉각적인 가치를 발휘할 수 있습니다. 특히, FP8 양자화가 대규모 모델의 실용적 배포를 앞당기는 핵심 기술임을 확인할 수 있습니다.

앞으로 FP8 기반 모델은 대규모 AI 활용의 표준이 될 가능성이 크며, Qwen3-Next-80B-A3B는 그 방향성을 보여주는 중요한 사례라 할 수 있습니다.

Alibaba Qwen Team Just Released FP8 Builds of Qwen3-Next-80B-A3B (Instruct & Thinking), Bringing 80B/3B-Active Hybrid-MoE to Com

Alibaba Qwen Team Just Released FP8 Builds of Qwen3-Next-80B-A3B (Instruct & Thinking), Bringing 80B/3B-Active Hybrid-MoE to Commodity GPUs

www.marktechpost.com

'인공지능' 카테고리의 다른 글

| AI 에이전트 시대, 코드 리뷰가 진짜 경쟁력이 되는 이유 (0) | 2025.09.23 |

|---|---|

| 윈드서프(Windsurf), 차세대 에이전틱 코딩 모델 Code-Supernova 공개 (0) | 2025.09.23 |

| GPT-5, 프론트엔드 개발의 게임 체인저일까? 유지보수 악몽일까? (0) | 2025.09.23 |

| 메타, 초소형 엣지 추론 모델 ‘모바일LLM-R1’ 공개 (0) | 2025.09.22 |

| 왜 글로벌 IT 기업들이 Agentgateway 프로젝트에 주목하는가? (0) | 2025.09.22 |