최근 들어 오픈소스 LLM의 성능이 눈에 띄게 향상되고 있습니다. 특히 GPT-4나 Claude와 같은 상용 모델과의 격차를 좁히며, 실제 개발 현장에서 사용할 수 있을 정도의 수준에 이르고 있는데요. 이번 블로그에서는 Mistral AI와 All Hands AI의 협업으로 탄생한 Devstral-Small-2505 모델에 대해 다룹니다.

이 글을 통해 Devstral이 어떤 모델인지, 어떤 기능과 특장점을 갖고 있으며 실제로 어떻게 활용할 수 있는지 알아봅니다. 또한 SWE-Bench 벤치마크 기준에서 보여준 성능과 함께, Devstral이 현업 개발자와 팀에게 어떤 가능성을 제공할 수 있을지도 함께 짚어보겠습니다.

Devstral-Small-2505란 무엇인가?

Devstral-Small-2505는 Mistral-Small-3.1 모델을 기반으로 파인튜닝된 오픈소스 LLM입니다. All Hands AI와 Mistral AI의 공동 협업으로 개발되었으며, 주된 목표는 **소프트웨어 엔지니어링 작업에 특화된 에이전트형 모델(agentic LLM)**을 만드는 것이었습니다.

기존 LLM은 범용적인 언어 이해에 초점을 맞춘 반면, Devstral은 코드 분석, 다중 파일 편집, 코드베이스 탐색 등 소프트웨어 개발 환경에서 발생하는 복합적인 작업에 특화돼 있습니다. 특히 로컬 환경에서도 실행 가능하다는 점에서 기업과 개인 개발자 모두에게 실용적인 선택지를 제공합니다.

Devstral의 주요 특징

1. Agentic Coding에 최적화

Devstral의 가장 큰 장점 중 하나는 'agentic coding' 기능입니다. 이 모델은 개발자의 작업 흐름을 이해하고, 다중 파일에 걸친 코드 편집이나 코드베이스 내 함수 구조 파악 등 자동화가 어려운 작업을 효과적으로 수행할 수 있도록 설계됐습니다.

2. 경량 모델로 로컬 실행 가능

Devstral은 24억 파라미터로 구성된 컴팩트한 모델입니다. 이는 RTX 4090 GPU나 32GB RAM을 탑재한 Mac에서도 실행이 가능하다는 뜻입니다. 고사양 서버나 클라우드 환경이 아니어도 모델을 테스트하거나 활용할 수 있다는 점은 개발자 입장에서 매우 큰 이점입니다.

3. 최대 128K 토큰의 컨텍스트 윈도우

대부분의 오픈소스 LLM이 제공하지 못하는 수준의 128K 토큰 컨텍스트 윈도우를 제공합니다. 이는 코드베이스 전체를 문맥으로 이해하고 처리할 수 있다는 것을 의미하며, 대규모 프로젝트의 일괄 리팩토링이나 분석 작업에서 강력한 성능을 보장합니다.

4. 오픈소스 Apache 2.0 라이선스

Devstral은 Apache 2.0 라이선스로 배포되어, 상업적 사용은 물론 모델 커스터마이징까지 자유롭게 활용 가능합니다. 이는 기업 내부 프로젝트에서도 부담 없이 도입할 수 있는 기반을 마련해줍니다.

5. Tekken Tokenizer 활용

131K 토큰의 어휘 집합을 가진 Tekken Tokenizer를 기반으로 하여, 다양한 개발 언어와 문법을 효율적으로 처리할 수 있습니다. 이는 코드 처리 능력과 자연어 간의 전환 정확도 향상에 기여합니다.

SWE-Bench 벤치마크 성능 비교

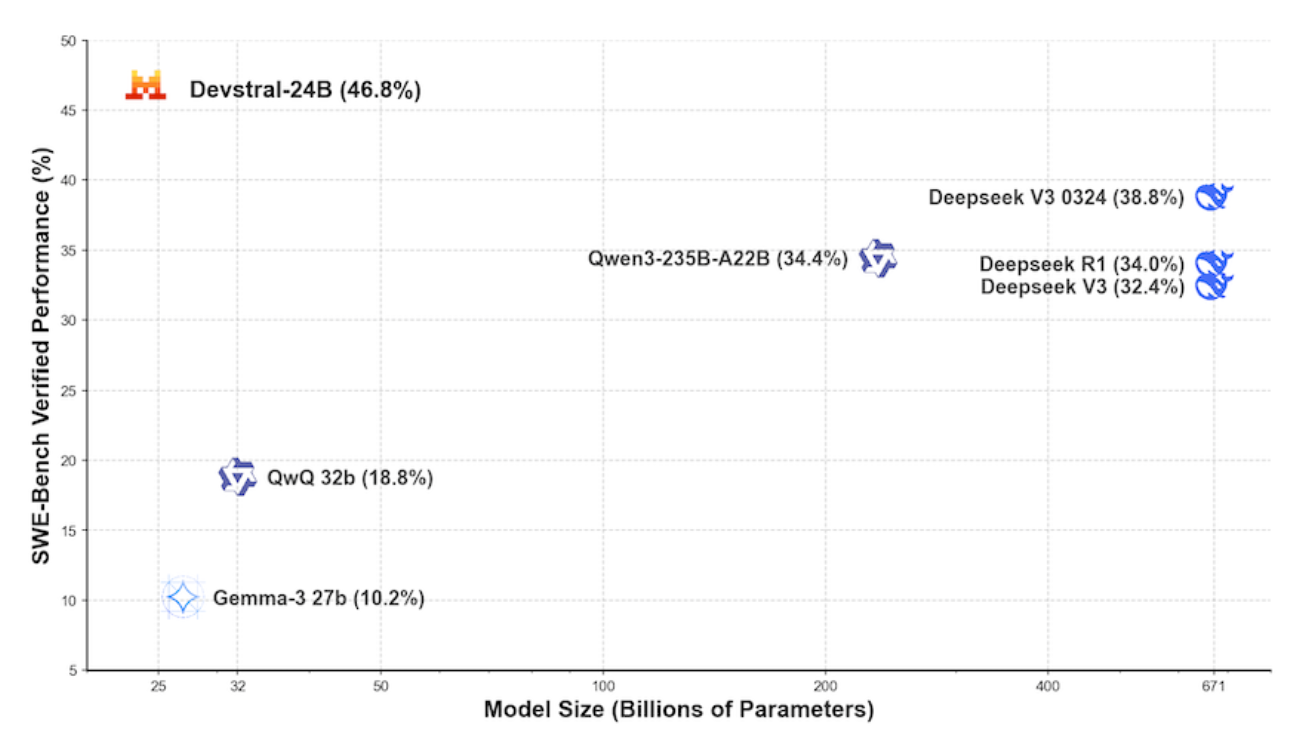

Devstral은 SWE-Bench Verified 기준으로 **46.8%**라는 점수를 기록했습니다. 이는 현재 오픈소스 기준에서 가장 높은 점수이며, 동일 조건(OpenHands scaffold) 하에서 다음과 같은 모델들과 비교해 월등한 성능을 보여줍니다.

| 모델명 | Scaffold | SWE-Bench Verified (%) |

| Devstral | OpenHands Scaffold | 46.8 |

| Claude 3.5 Haiku | Anthropic Scaffold | 40.6 |

| SWE-smith-LM 32B | SWE-agent Scaffold | 40.2 |

| GPT-4.1-mini | OpenAI Scaffold | 23.6 |

이는 단순히 성능뿐만 아니라, Devstral이 실제로 코드 수정과 제안, 이해 및 실행 능력에 있어 실용적인 수준이라는 점을 입증합니다.

Devstral 사용 방법

Devstral은 OpenHands scaffold 환경에서 사용될 것을 권장합니다. 두 가지 방식으로 접근이 가능합니다.

1. API를 통한 사용

All Hands AI에서 제공하는 API를 통해 클라우드 기반으로 Devstral을 사용할 수 있습니다. 이는 빠르게 실험해보고 싶은 개발자에게 적합합니다.

2. 로컬 환경 실행

Devstral은 경량 모델이기 때문에 로컬 환경에서 직접 실행이 가능합니다. RTX 4090이나 32GB RAM 이상의 Mac 사용자라면 설치 후 즉시 테스트가 가능합니다.

설정 예시나 세팅 가이드는 All Hands AI 공식 블로그에서 제공되고 있으므로, 참고하면 쉽게 사용할 수 있습니다.

Devstral-Small-2505는 성능, 유연성, 오픈소스 라이선스라는 세 가지 강점을 갖춘 모델입니다. SWE-Bench 성능이 입증하듯이, 단순한 실험용 LLM이 아닌 실제 프로젝트에 도입 가능한 실용적 LLM입니다.

무거운 모델을 쓰기 어려운 스타트업이나 개인 개발자에게는 비용과 성능 사이의 균형을 잡을 수 있는 이상적인 선택지이며, 대기업이나 기술 조직에서는 빠른 프로토타이핑이나 모델 비교 실험용으로도 유용하게 활용할 수 있습니다.

앞으로 Devstral은 오픈소스 LLM 생태계에서 중요한 전환점을 제공할 수 있으며, 에이전트 기반 개발 환경에서 핵심 역할을 할 수 있을 것으로 기대됩니다.

mistralai/Devstral-Small-2505 · Hugging Face

Devstral-Small-2505 Devstral is an agentic LLM for software engineering tasks built under a collaboration between Mistral AI and All Hands AI 🙌. Devstral excels at using tools to explore codebases, editing multiple files and power software engineering a

huggingface.co

'인공지능' 카테고리의 다른 글

| 오픈 소스 임베딩 모델, 무엇이 최적인가? RAG를 위한 평가 워크플로우 완전 정복 (0) | 2025.05.31 |

|---|---|

| 코드 임베딩의 새로운 기준, Codestral Embed의 모든 것 (0) | 2025.05.31 |

| AI 챗봇도 목소리 시대! 클로드 음성 모드가 특별한 이유는? (0) | 2025.05.30 |

| AI 응답 품질을 평가하는 가장 스마트한 방법 - Microsoft.Extensions.AI.Evaluation 라이브러리 완전 정복 (0) | 2025.05.30 |

| Gemini Diffusion: 생성형 AI의 새로운 게임 체인저 (0) | 2025.05.30 |