AI 기술 진화의 다음 단계, Meta FAIR의 야심찬 도전

"AI가 정말 사람처럼 사고하고 볼 수 있을까?"

이 질문에 대한 대답을 향해 한걸음 더 나아간 연구 결과가 공개됐습니다. 바로 Meta의 AI 연구 조직 **FAIR(Fundamental AI Research)**가 발표한 다섯 가지 새로운 기술입니다.

이번에 공개된 기술들은 단순한 AI 성능 향상을 넘어서, 시각 인식, 언어 이해, 3D 공간 인식, 바이트 레벨 언어 처리, 그리고 협업 추론 능력까지 AI의 전반적인 인지 능력을 강화하는 데 초점이 맞춰져 있습니다.

각 기술은 모두 오픈소스로 제공되어 누구나 실험하고 활용할 수 있습니다. 이 블로그에서는 각 기술이 어떤 문제를 해결하며, 어떤 방식으로 작동하고, 무엇이 특별한지를 쉽게 정리해드립니다.

👁️ Perception Encoder: AI에게 ‘눈’을 달아주다

▸ 무엇을 해결하려고 했을까?

기존의 컴퓨터 비전 시스템은 특정 작업에만 최적화되어 있어, 다양한 상황이나 미묘한 차이를 구분하는 데 한계가 있었습니다. 예를 들어, 땅에 반쯤 묻힌 가오리나 배경 속 작은 새를 인식하는 건 매우 어려운 일이었죠.

▸ 무엇이 특별한가?

Meta Perception Encoder는 이미지와 비디오를 동시에 잘 다룰 수 있는 대규모 비전 인코더입니다.

- Zero-shot 분류 및 검색 성능에서 모든 오픈소스·상용 모델을 능가

- 희귀하고 어려운 이미지도 정확하게 인식 (예: 밤중 야생동물 카메라 속 아구티 포착)

- 언어와 연결되어 시각질문응답(VQA), 캡셔닝, 문서 이해 등에서도 높은 성능

▸ 왜 중요한가?

이 기술은 단순한 객체 인식을 넘어, AI가 세상을 더 잘 이해하고 설명할 수 있게 만들어 줍니다. 이는 자율주행, 로봇 비전, 이미지 검색 등 다양한 분야에 응용 가능합니다.

🧠 Perception Language Model (PLM): 시각 + 언어 = 최강 조합

▸ 문제는 데이터였다

기존의 비전-언어 모델은 대규모 학습 데이터를 확보하는 데 한계가 있었고, 대부분 외부 모델을 이용한 ‘지식 증류’에 의존했습니다.

▸ PLM의 접근법

**PLM(Perception Language Model)**은 외부 모델에 의존하지 않고,

- 합성 데이터와

- 250만 개 이상의 사람 손으로 라벨링한 비디오 QA/캡션 데이터를 이용해

직접 학습시킨 모델입니다.

▸ 특징

- 1B, 3B, 8B 파라미터 버전으로 공개되어 연구용으로 최적

- PLM-VideoBench라는 새로운 벤치마크 제공 (기존 벤치마크에서 다루지 않던 미세활동 인식, 시공간 추론 등 테스트)

PLM은 실제로 얼마나 다양한 시각적 개체를 인식하고, 어떻게 언어로 설명하는지를 시험할 수 있게 해줍니다.

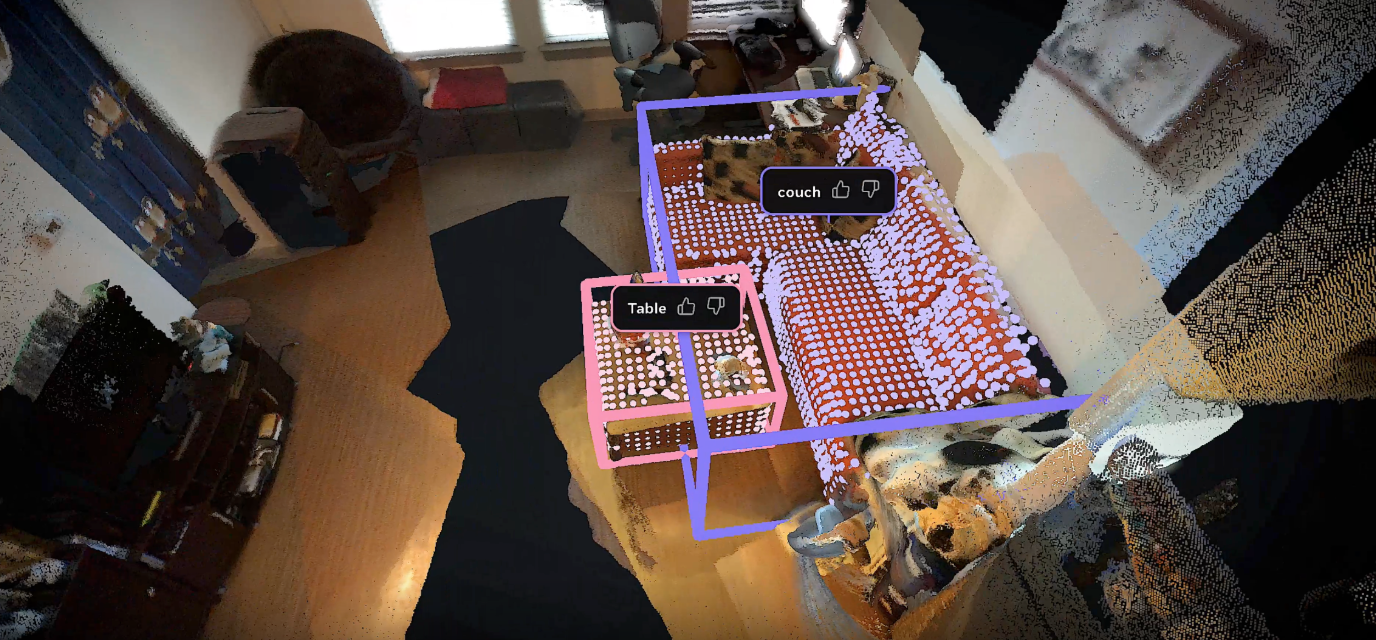

📦 Meta Locate 3D: “빨간 컵 가져다 줘”에 반응하는 AI

▸ 문제 상황

“식탁 위에 있는 빨간 컵 가져다줘”라고 말했을 때, 로봇이 정확히 그 컵을 알아보고 움직이기 위해서는 단순한 물체 인식이 아닌 3D 공간 이해가 필요합니다.

▸ Meta Locate 3D의 구조

- 2D 데이터를 3D 포인트 클라우드로 변환

- 3D-JEPA 인코더: 장면의 3D 표현 생성

- Locate 3D 디코더: 텍스트 명령에 따라 해당 객체 위치를 정확히 찾아냄

▸ 주요 성능

- “TV 근처의 꽃병” vs “책상 위의 꽃병”처럼 미묘한 차이를 인식

- ScanNet, ARKitScenes 등 주요 데이터셋에서 130,000개의 언어 주석 제공

- 실제 로봇 시스템에 적용 가능한 수준

이 모델은 향후 로봇 보조 시스템, 스마트 홈 디바이스 등에서 자연어 기반 조작의 핵심 기술이 될 수 있습니다.

💾 Dynamic Byte Latent Transformer: 토크나이저 없이도 강력한 성능

▸ 기존 한계

기존 LLM은 모두 토크나이저를 사용합니다. 하지만 이는 언어마다 맞춤이 필요하고, 에러에도 취약하죠.

▸ 새로운 접근: 바이트 기반 처리

Dynamic Byte Latent Transformer는 텍스트를 바이트 단위로 처리하는 새로운 언어 모델입니다.

- 기존 토크나이저 기반 모델과 동등한 성능

- **내구성(robustness)**에서는 +7~+55포인트까지 우위

- 특히 문법이 틀리거나 비표준 표현이 포함된 입력에서도 성능 유지

이 기술은 언어 독립적이며 더 빠르고 안정적인 LLM 개발을 가능하게 합니다.

🤝 Collaborative Reasoner: AI도 ‘같이 생각’할 수 있을까?

▸ 핵심 질문

혼자 생각하는 AI보다, 다른 AI 또는 사람과 협업해 문제를 해결하는 AI는 가능할까?

▸ 어떻게 작동하나?

Collaborative Reasoner는 다음을 통해 협업 추론 능력을 평가하고 개선합니다:

- 목표 지향적 다중 턴 대화 과제 제공

- AI가 서로 의견을 나누고 설득하고 합의하는 과정을 학습

- **자기 협업(Self-Collaboration)**이라는 기법으로 데이터 대량 생성

▸ 결과는?

- 단일 LLM보다 최대 29.4% 성능 향상

- 수학, 과학, 사회적 추론 과제에서 탁월한 성과

이 기술은 향후 지능형 교육 도우미, 상담 AI, 팀 기반 에이전트 시스템 개발에 중요한 기반이 될 수 있습니다.

지금 이 기술을 주목해야 하는 이유

Meta FAIR가 공개한 이번 5가지 기술은 단순한 성능 향상을 넘어, AI가 세상을 이해하고, 언어로 표현하며, 사람과 협력하는 능력에 근접하도록 만든 시도입니다.

| 기술 | 핵심 키워드 |

| Perception Encoder | 초정밀 시각 인식 |

| PLM | 비전-언어 통합 학습 |

| Locate 3D | 자연어 기반 3D 물체 인식 |

| Byte Latent Transformer | 언어 독립 바이트 기반 모델 |

| Collaborative Reasoner | 협업 추론 AI |

Advancing AI systems through progress in perception, localization, and reasoning

To address this, we built Meta Locate 3D, an end-to-end model that can accurately localize objects from open-vocabulary queries. Meta Locate 3D directly operates on 3D point clouds from RGB-D sensors that are received from a robot. When given a text prompt

ai.meta.com

'인공지능' 카테고리의 다른 글

| 터미널 속 개발 파트너, Claude Code를 아시나요? - 개발 생산성을 극대화하는 에이전틱 코딩 도구 완전 정복 가이드 (0) | 2025.04.20 |

|---|---|

| 생성형 AI 앱, 어렵지 않아요! Google AI Studio Starter Apps 체험기 (0) | 2025.04.20 |

| genai-toolbox - “데이터베이스에 AI 도구 연결, 이렇게 간편해도 되나?” — MCP Toolbox for Databases 완벽 정리 (0) | 2025.04.20 |

| “코드 주석, 이젠 AI가 제대로 한다” — DocAgent로 살펴보는 차세대 자동 문서화 시스템 (0) | 2025.04.20 |

| 이제 코드 없이 AI 자동화? n8n과 MCP 통합으로 열리는 AI 워크플로우 혁신 시대 (0) | 2025.04.19 |