LLM, 이제 도구까지 '생각해서' 쓴다?

요즘 AI 개발자라면 누구나 한 번쯤 이런 고민을 했을 겁니다.

"LLM(대형언어모델)이 똑똑하긴 한데, 새로운 툴을 쓸 땐 또 훈련을 시켜야 하잖아?"

맞습니다. 그동안 LLM이 외부 애플리케이션이나 도구를 쓰려면 그 도구에 맞춰 별도로 미세조정을 해야 했죠. 문제는 이 과정이 번거롭고, 모델의 본래 성능까지 해칠 수 있다는 점이었습니다.

그런데 최근, 중국 쑤저우대학교 연구진이 전혀 다른 접근법을 제시했습니다. LLM을 다시 훈련하지 않고도, 처음 보는 도구까지도 유연하게 사용할 수 있는 프레임워크를 만들었다는 소식입니다. 그 이름이 바로 **‘도구 사슬(CoTools)’**입니다.

이 글에서는 이 혁신적인 기술이 어떻게 작동하는지, 기존 방식과 무엇이 다른지, 그리고 실제로 어느 정도 성능을 내는지를 쉽고 명확하게 풀어보겠습니다.

🔍 ‘도구 사슬(CoTools)’이란?

‘도구 사슬(CoTools)’은 대형언어모델(LLM)이 훈련되지 않은 새로운 도구도 적절하게 사용할 수 있도록 돕는 프레임워크입니다.

기존 방식이 모델을 다시 학습시켜야 했다면, CoTools는 학습 없이도 새로운 도구를 사용할 수 있도록 합니다. 핵심 아이디어는 **LLM의 숨겨진 상태(hidden state)**를 활용하는 것입니다.

LLM이 문장을 생성하는 중간 단계에서 만들어지는 이 ‘숨겨진 상태’를 분석해,

*“지금 이 시점에 어떤 도구를 써야 적절할까?”*를 판단하고,

적절한 도구를 검색하고 호출하는 구조입니다.

즉, 모델을 ‘손대지 않고(frozen)’도 의미적 판단과 도구 선택이 가능해지는 거죠.

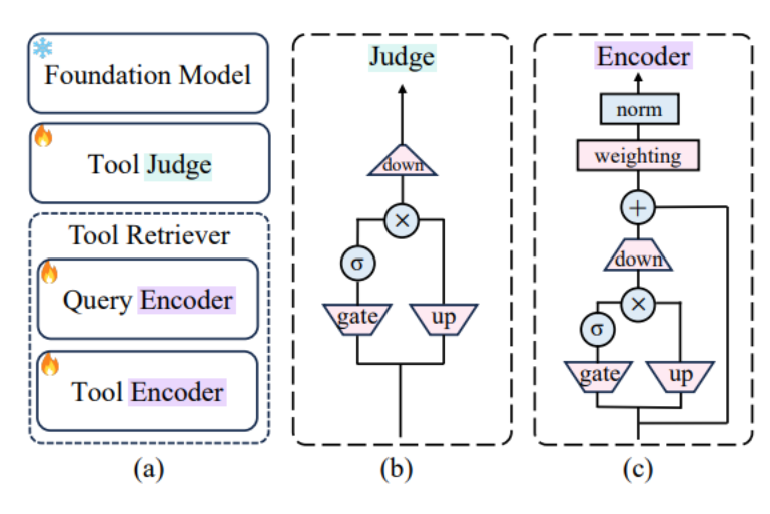

🧠 기술 구성 – 세 가지 모듈로 완성된 ‘도구 사슬’

도구 사슬은 아래 세 가지 모듈로 구성됩니다:

1. 도구 판단기 (Tool Judge)

- LLM의 숨겨진 상태를 분석해 지금 시점에서 도구 호출이 필요한지를 판단합니다.

- 예를 들어, 모델이 계산이나 외부 지식이 필요한 질문을 마주쳤을 때 이를 감지합니다.

2. 도구 검색기 (Tool Retriever)

- 판단기가 “도구가 필요하다”고 판단하면, 수많은 도구 중에서 가장 적절한 도구를 찾아냅니다.

- 이 검색기는 쿼리(질문)에 가장 알맞은 도구를 매칭할 수 있도록 훈련되어 있습니다.

3. 도구 호출기 (Tool Calling via ICL)

- 선택된 도구를 실제로 호출하는 단계입니다.

- 이 때는 모델이 미리 학습한 것이 아닌, 프롬프트 내 예시(ICL)를 통해 도구를 처음 보더라도 사용할 수 있게 만듭니다.

✏️ ICL(In-Context Learning)이란?

모델이 본문 중간에 제공된 예시나 설명을 보고 그 문맥 안에서 ‘학습’하는 방식입니다. 훈련된 건 아니지만, ‘흉내’를 낼 수 있게 만드는 기술입니다.

⚙️ 기존 방식과는 뭐가 다른가요?

| 기존 방식 도구 | 사슬 방식 |

| 도구 사용을 위해 모델 재학습 필요 | 재학습 없이도 유연하게 도구 사용 가능 |

| 성능 저하 우려 있음 | 모델 본연의 성능을 유지함 |

| 훈련된 도구만 사용 가능 | 처음 보는 도구도 사용 가능 |

| 도구 호출 로직이 복잡함 | 프롬프트 기반으로 간단한 호출 가능 |

이처럼 도구 사슬은 추론과 실행을 완전히 분리하면서도, 도구 호출의 자유도와 정확성을 크게 높여줍니다.

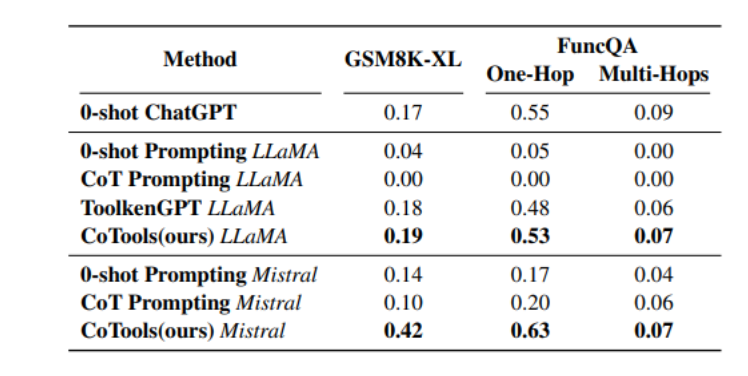

📊 성능은? – 실제 벤치마크 결과

연구진은 이 프레임워크를 **오픈 소스 모델 ‘라마 2-7B(LLaMA 2-7B)’**에 적용해 여러 벤치마크 테스트를 진행했습니다.

1. GSM8K-XL (기초 수학 연산 능력 평가)

- 챗GPT와 비슷한 수준의 정확도를 기록

- 복잡하지 않은 계산에서 충분히 쓸 만한 수준

2. FuncQA (복잡한 수학 함수 테스트)

- 기존 ToolkenGPT와 유사하거나 더 나은 성능

- 다양한 수학 함수를 필요에 따라 잘 선택

3. KBQA (지식 기반 질의응답)

- 1836개의 도구 중 837개는 처음 보는 도구였음에도 높은 정확도 기록

- 도구 선택 정확도 우수 → 실제 실무에서도 기대됨

🌐 실무에 어떻게 쓰일 수 있을까?

이 프레임워크는 **MCP(Model Context Protocol)**와 잘 어울립니다.

즉, 도구 사슬을 활용하면 기업은 LLM을 다시 학습시키지 않아도 외부 시스템이나 도구와 연결되는 AI 에이전트를 만들 수 있습니다.

예를 들어:

- 고객센터 봇이 처음 보는 사내 문서 검색 시스템과도 바로 연동

- 엔지니어링 툴과 연결해 도면 계산 등 복잡한 작업 수행 가능

- 과학자들이 분석 툴을 바꾸더라도 AI가 바로 적응 가능

도구 사슬이 열어가는 ‘유연한 AI’의 시대

도구 사슬(CoTools)은 단순히 새로운 기술 하나가 아니라,

LLM이 실제 세계와 더 유연하게 상호작용할 수 있는 방향을 제시하는 기술입니다.

✅ 핵심 요약:

- 모델은 ‘동결된 상태’로 유지

- ‘숨겨진 상태’를 분석해 도구 사용 판단

- 처음 보는 도구도 프롬프트 기반으로 사용 가능

- 성능도 뛰어남, 특히 도구 선택 정확도에서 강점

아직은 실험적 단계에 머무르고 있지만, 개발자와 기업 입장에서 보면 매우 실용적인 해법입니다.

앞으로 에이전트 기반 시스템을 구축할 때, ‘도구 사슬’은 꼭 눈여겨봐야 할 기술 중 하나가 될 것입니다.

💡 기대되는 점:

- AI 개발의 생산성이 획기적으로 향상될 가능성

- 도구 추가에 대한 부담 없이 더 많은 기능 통합 가능

- ‘AI가 도구를 배워야 하는 시대’에서 → ‘AI가 도구를 스스로 사용하는 시대’로의 전환

https://www.arxiv.org/abs/2503.16779

Chain-of-Tools: Utilizing Massive Unseen Tools in the CoT Reasoning of Frozen Language Models

Tool learning can further broaden the usage scenarios of large language models (LLMs). However most of the existing methods either need to finetune that the model can only use tools seen in the training data, or add tool demonstrations into the prompt with

arxiv.org

'인공지능' 카테고리의 다른 글

| 70B가 109B를 이겼다고? 새로운 오픈소스 LLM ‘Cogito’가 주목받는 이유 (0) | 2025.04.11 |

|---|---|

| Vectara의 ‘Open RAG Eval’로 AI 응답 품질, 더 이상 감으로 판단하지 마세요 (0) | 2025.04.11 |

| 구글이 AI 리서치를 바꾼다? ‘노트북LM’에 웹 검색 기능까지 추가된 Gemini Deep Research의 진화 (0) | 2025.04.10 |

| 구글의 차세대 추론 전용 TPU, Ironwood 전격 해부 (0) | 2025.04.10 |

| Google이 내부에서 쓰던 대규모 AI 학습 기술, 이제 GKE에서? – Pathways 완전 정리 (0) | 2025.04.10 |