Transformer는 자연어 처리(NLP)와 기타 시퀀스 기반의 작업에서 주로 사용되는 딥러닝 모델의 일종입니다. 2017년 구글의 연구팀이 발표한 논문 "Attention is All You Need"에서 처음 소개되었습니다. Transformer는 그 이전에 주로 사용되던 순환 신경망(RNN)과 장단기 기억 네트워크(LSTM)의 한계를 극복하기 위해 설계되었습니다.

Transformer의 주요 구성 요소

- Self-Attention Mechanism (자기 주의 메커니즘): 입력 시퀀스의 각 요소가 다른 모든 요소들과의 관계를 학습하여 중요한 정보를 선택적으로 집중할 수 있게 합니다. 이 메커니즘 덕분에 Transformer는 병렬 처리가 가능하며, 긴 시퀀스의 입력에서도 효과적으로 학습할 수 있습니다.

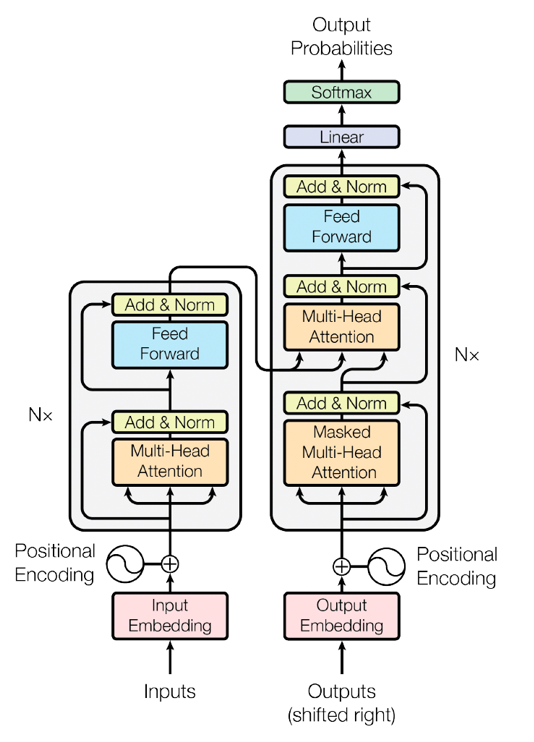

- Encoder-Decoder 구조: Transformer 모델은 인코더와 디코더 두 부분으로 구성됩니다. 인코더는 입력 시퀀스를 처리하고, 디코더는 인코더의 출력을 받아서 원하는 출력을 생성합니다. 이 구조는 번역과 같은 시퀀스-투-시퀀스 작업에 특히 유용합니다.

- Multi-Head Attention: 단일 Self-Attention 레이어를 여러 개 사용하는 기법으로, 모델이 다양한 위치의 패턴을 동시에 학습할 수 있게 합니다. 이를 통해 더 풍부한 표현 학습이 가능해집니다.

- Positional Encoding: Transformer는 순서를 갖지 않는 병렬 처리의 특성상 입력 데이터의 순서 정보를 학습할 수 없기 때문에, 입력 시퀀스의 각 위치에 대한 정보를 추가로 인코딩하여 모델에 제공됩니다.

Transformer의 이러한 특징 덕분에 BERT, GPT와 같은 강력한 NLP 모델들이 개발될 수 있었습니다. 이들은 다양한 자연어 처리 작업에서 최첨단 성능을 보여주고 있습니다.

Transformer의 중요성

트랜스포머(Transformer)가 중요한 이유는 여러 가지가 있습니다. 주로 자연어 처리(NLP) 분야에서 혁신적인 발전을 이룬 모델로서, 기존의 RNN(Recurrent Neural Network) 및 LSTM(Long Short-Term Memory) 모델들이 갖고 있던 한계를 극복했기 때문입니다.

| 구분 | 내용 |

| 병렬 처리 가능성 | 기존의 RNN과 LSTM은 순차적으로 데이터를 처리해야 하므로 병렬 처리가 어려웠습니다. Transformer는 Self-Attention 메커니즘을 사용하여 입력 시퀀스를 병렬로 처리할 수 있어 학습 속도가 크게 향상되었습니다. |

| 장기 의존성 문제 해결 | RNN과 LSTM은 긴 시퀀스에서의 장기 의존성(Long-term dependencies)을 학습하는 데 어려움이 있었습니다. Transformer는 Self-Attention 메커니즘을 통해 시퀀스의 모든 위치를 서로 연결할 수 있어 장기 의존성을 효과적으로 학습할 수 있습니다. |

| 효율적인 학습과 성능 | Transformer 모델은 학습 과정에서 더 적은 연산 자원으로도 더 빠르게 학습할 수 있으며, 기존 모델들보다 더 높은 성능을 발휘합니다. BERT, GPT와 같은 모델들은 다양한 NLP 태스크에서 최고 수준의 성능을 보여주고 있습니다. |

| 다양한 응용 분야 | Transformer는 자연어 처리 뿐만 아니라 이미지 처리, 음성 인식, 추천 시스템 등 다양한 분야에서 적용 가능하며 성공적인 결과를 보여주고 있습니다. 예를 들어, Vision Transformer(ViT)는 이미지 분류 작업에서 탁월한 성능을 보여줍니다. |

| 모듈화와 확장성 | Transformer의 구조는 매우 모듈화되어 있어 다양한 변형과 확장이 가능합니다. 예를 들어, GPT-3는 수십억 개의 파라미터를 가진 대규모 모델로서, 문장 생성, 번역, 요약 등 여러 NLP 태스크를 수행할 수 있습니다. |

| Self-Attention의 유연성 | Self-Attention 메커니즘은 입력 시퀀스의 각 요소가 다른 모든 요소들과의 관계를 학습할 수 있게 하여, 문맥을 이해하고 중요한 정보를 선택적으로 집중할 수 있게 합니다. 이는 특히 언어 모델링에서 문맥 이해도를 높이는 데 큰 기여를 합니다. |

Transformer는 이러한 이유들로 인해 딥러닝과 인공지능 연구의 중요한 도구로 자리잡았으며, 지속적으로 발전하고 있는 모델입니다. 이를 통해 다양한 분야에서 혁신적인 기술 발전을 이루고 있습니다.

트랜스포머의 아키텍처의 구성 요소

트랜스포머(Transformer) 모델은 자연어 처리(NLP)와 다양한 시퀀스 기반 작업에서 중요한 역할을 하는 딥러닝 아키텍처입니다. 트랜스포머는 순차적 처리의 한계를 극복하며 병렬 처리와 장기 의존성 문제를 효과적으로 해결하는 혁신적인 접근법을 제공합니다.

1. 입력 임베딩 (Input Embedding)

입력 임베딩 단계는 입력 시퀀스를 소프트웨어 알고리즘이 이해할 수 있는 수학적 벡터로 변환하는 과정입니다. 처음에는 입력 시퀀스를 토큰, 즉 개별 시퀀스 구성 요소로 나눕니다. 예를 들어, 문장이라면 토큰은 단어입니다. 임베딩은 이러한 토큰 시퀀스를 수학적 벡터 시퀀스로 변환합니다. 벡터는 숫자로 표현되는 의미 및 구문 정보를 전달하며, 벡터의 속성은 훈련 과정에서 학습됩니다.

벡터는 n차원 공간에서 일련의 좌표로 시각화할 수 있습니다. 간단한 예로, 2차원 그래프에서 x축은 단어의 첫 글자의 영숫자 값을, y축은 단어의 범주를 나타낼 수 있습니다. 예를 들어, "바나나"라는 단어는 b로 시작하고 과일 범주에 속하므로 (2,2)로 표현될 수 있습니다. 이처럼 벡터는 모델이 단어 간의 관계를 수학적으로 이해할 수 있게 도와줍니다.

2. 위치 인코딩 (Positional Encoding)

트랜스포머 모델은 본질적으로 순차 데이터를 순서대로 처리하지 않기 때문에 위치 인코딩이 필요합니다. 위치 인코딩은 입력 시퀀스의 토큰 순서를 모델에 전달하기 위해 각 토큰의 임베딩에 추가적인 위치 정보를 부여합니다. 이는 함수 세트를 사용하여 각 토큰의 임베딩에 고유한 위치 신호를 생성함으로써 이루어집니다. 이를 통해 모델은 토큰의 순서를 보존하고 시퀀스 컨텍스트를 이해할 수 있게 됩니다.

3. 트랜스포머 블록 (Transformer Block)

트랜스포머 모델은 여러 개의 트랜스포머 블록이 적층된 형태로 구성됩니다. 각 블록은 두 가지 주요 구성 요소를 포함합니다: 멀티헤드 셀프 어텐션(Multi-Head Self-Attention) 메커니즘과 위치별 피드포워드 신경망(Position-wise Feed-Forward Neural Network).

3.1 멀티헤드 셀프 어텐션 (Multi-Head Self-Attention) 셀프 어텐션 메커니즘을 통해 모델은 시퀀스 내에서 각 토큰의 중요도를 평가할 수 있습니다. 이는 입력의 관련 부분에 초점을 맞추어 예측을 개선합니다. 예를 들어, "거짓말을 하지 마세요(Speak no lies)"와 "그는 누웠다(He lies down)"에서 "lies"의 의미는 주변 단어를 통해 결정됩니다. 셀프 어텐션은 이와 같이 컨텍스트에 맞는 관련 토큰을 그룹화할 수 있습니다.

3.2 위치별 피드포워드 신경망 (Position-wise Feed-Forward Neural Network) 피드포워드 계층은 각 트랜스포머 블록 내의 추가적인 구성 요소로, 모델이 더 효율적으로 학습하고 기능하는 데 도움을 줍니다. 각 트랜스포머 블록에는 다음이 포함됩니다:

- 잔차 연결 (Residual Connection): 두 주요 구성 요소 주위에 연결되어 정보가 네트워크의 다른 부분으로 원활하게 흐를 수 있게 합니다.

- 계층 정규화 (Layer Normalization): 여러 계층의 출력값을 특정 범위 내로 유지하여 모델의 학습 안정성을 높입니다.

- 선형 변환 (Linear Transformation): 모델이 훈련 중인 작업을 더 잘 수행할 수 있도록 값을 조정합니다.

4. 선형 및 소프트맥스 블록 (Linear and Softmax Layer)

트랜스포머 모델은 최종적으로 구체적인 예측을 해야 합니다. 이를 위해 선형 블록이 필요합니다. 이 계층은 벡터 공간에서 원래 입력 도메인으로 학습된 선형 매핑을 수행합니다. 선형 계층의 출력은 가능한 각 토큰에 대한 점수 집합(로짓)을 생성합니다. 소프트맥스(Softmax) 함수는 이 로짓 점수를 확률 분포로 정규화합니다. 소프트맥스 출력의 각 요소는 특정 클래스 또는 토큰에 대한 모델의 신뢰도를 나타냅니다.

트랜스포머의 사용사례

트랜스포머(Transformer) 모델은 다양한 분야에서 혁신적인 발전을 이루어내며 광범위하게 사용되고 있습니다.

| 구분 | 내용 |

| 자연어 처리 (NLP) |

|

| 이미지 처리 |

|

| 음성 인식 |

|

| 추천 시스템 |

|

| 바이오 인포매틱스 |

|

'인공지능' 카테고리의 다른 글

| 효율적인 인공지능 Fine Tuning: PEFT에 대해 알아보기(개념 잡기) (0) | 2024.08.19 |

|---|---|

| [LLM] 인공지능, 학습되지 않은 지식을 얻는 두 가지 비법: Fine Tuning과 RAG 개 (0) | 2024.08.19 |

| [AGI] AGI(인공 일반 지능)란 무엇인가? (0) | 2024.07.11 |

| [AI Agent] AI 에이전트란 무엇인가? (0) | 2024.07.11 |

| [XAI] 설명 가능한 AI란 무엇인가? (0) | 2024.07.01 |