LLM 성능 향상을 위한 새로운 해법, CODEI/O란 무엇인가?

최근 인공지능 연구에서 대규모 언어 모델(LLM)의 성능 한계에 대한 고민이 커지고 있습니다. 수학 문제, 논리 추론, 코드 생성 등 복잡한 작업에서 기대만큼의 성과가 나오지 않거나, 특정 분야에만 강점을 보이고 다른 영역에서는 한계를 드러내는 경우가 많기 때문입니다.

그런데 최근 이 문제를 해결할 수 있는 흥미로운 접근법이 제시됐습니다. 바로 CODEI/O라는 훈련 방식입니다. DeepSeek 연구팀이 발표한 이 방법은, 모델에게 단순히 텍스트나 코드 문법을 익히게 하는 것이 아니라, 코드의 입력과 출력을 예측하는 과정에서 추론 능력을 자연스럽게 강화시키는 방식입니다.

쉽게 말해, 사람에게 논리적으로 코딩을 잘하게 가르치면, 자연스럽게 문제 해결 능력이나 논리적 사고도 같이 좋아지듯이, LLM도 코드로 훈련시키면 추론 전반에 걸쳐 능력이 골고루 향상된다는 것입니다.

이 블로그에서는

✅ CODEI/O가 무엇인지,

✅ 왜 코드 학습이 LLM 추론 강화에 효과적인지,

✅ 실제로 성능이 얼마나 좋아졌는지,

✅ 이 기술이 우리 실무에 어떤 의미가 있는지

차근차근 살펴보겠습니다.

LLM의 성능을 한 단계 더 끌어올릴 방법을 찾고 있다면, CODEI/O가 그 돌파구가 될 수 있습니다.

1. LLM 성능 한계, 새로운 돌파구가 필요하다

최근 LLM을 활용해본 개발자라면 누구나 한 번쯤 이런 생각을 해봤을 겁니다.

“기본적인 답변은 괜찮은데, 조금만 복잡한 문제로 가면 결과가 엉망이네.”

“수학이나 논리 문제만 나오면 이상한 소리를 하는데?”

“코드 생성은 그럭저럭 하는데, 논리적으로 추론하는 작업은 아직 멀었다.”

이런 문제는 LLM이 학습한 데이터의 한계와도 연관이 있습니다.

코드 생성이나 수학 문제처럼 명확한 구조가 있는 데이터는 비교적 잘 다룹니다.

반면에 논리적 추론, 과학적 문제 해결, 상황에 맞는 의사결정처럼 추론 능력이 중요한 작업에서는 쉽게 벽에 부딪힙니다.

그렇다면, 이 추론 능력을 골고루 강화할 방법은 없을까요?

DeepSeek의 CODEI/O는 바로 이 질문에서 출발했습니다.

2. CODEI/O란? – 코드 입력과 출력으로 추론 능력을 길러라

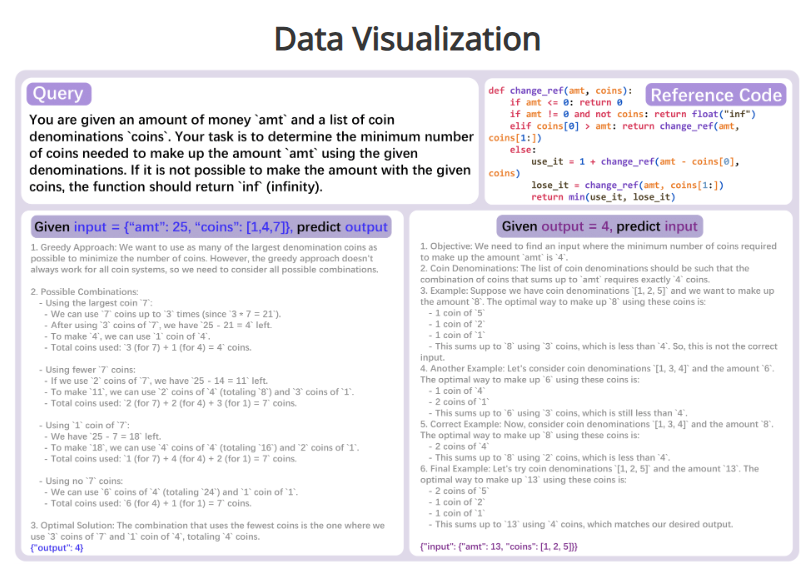

CODEI/O는 간단히 말하면, 코드의 입력과 출력을 예측하는 방식으로 LLM을 훈련시키는 접근법입니다.

구체적으로는 다음과 같은 방식입니다.

- 코드와 테스트 케이스(입력/출력)가 주어졌을 때,

- 입력이 주어지면 출력을 Chain-of-Thought(CoT) 방식으로 추론하도록 훈련하거나

- 반대로 출력이 주어지면 가능한 입력을 추론하도록 훈련합니다.

예를 들어, 이런 식입니다.

def add(a, b):

return a + b

이 코드와 함께 입력 (3, 5)가 주어졌다면, 모델은 다음과 같이 자연어로 출력 과정을 추론합니다.

입력 a=3, b=5가 주어졌습니다.

함수 add는 두 값을 더하는 기능입니다.

3 + 5 = 8이므로, 출력은 8입니다.

반대로 출력 8이 주어졌다면, 가능한 입력 (3, 5)를 추론하도록 유도합니다.

이 훈련 과정에서 LLM은 단순히 정답을 맞히는 것이 아니라,

문제를 이해하고 논리적으로 과정을 설명하며 답을 도출하는 능력을 키우게 됩니다.

3. 왜 코드 학습이 추론 강화에 효과적일까?

그렇다면 왜 코드가 추론 능력을 키우는 데 효과적일까요?

이유는 간단합니다.

코드는 논리 흐름, 상태 변화, 조건 분기, 반복 구조와 같이

추론에 필요한 거의 모든 요소를 포함하고 있기 때문입니다.

사람도 코딩을 배우면 자연스럽게 논리적 사고와 문제 해결 능력이 좋아집니다.

LLM도 마찬가지입니다.

CODEI/O 훈련을 통해 모델은 다음과 같은 추론 패턴에 반복적으로 노출됩니다.

- 논리 흐름 계획

- 상태 공간 탐색

- 의사결정 트리 순회

- 모듈식 분해

이 과정에서 모델은 자연스럽게 복합적인 문제 해결 능력을 내재화하게 됩니다.

4. CODEI/O의 핵심 구성과 동작 방식

CODEI/O는 크게 네 단계로 이루어집니다.

- 코드 수집

- 다양한 소스에서 실제 코드 파일을 수집합니다.

- 코드 정제 및 변환

- 수집한 코드에서 핵심 기능만 추출해 실행 가능한 함수로 변환합니다.

- 입력/출력 쌍 생성

- 변환된 함수에서 다양한 입력과 출력을 샘플링합니다.

- 입출력 예측 훈련

- 모델에게 코드와 입력을 주고 출력을 추론하거나,

코드와 출력을 주고 입력을 추론하도록 학습합니다.

- 모델에게 코드와 입력을 주고 출력을 추론하거나,

이러한 과정을 거쳐 CODEI/O는

코드와 자연어 추론 과정을 함께 학습하도록 유도합니다.

5. 성능 향상은 어느 정도인가? – 실험 결과와 벤치마크 분석

DeepSeek 연구팀은 CODEI/O를 적용한 모델을 다양한 벤치마크에서 테스트했습니다.

대표적인 결과는 다음과 같습니다.

평가 항목 성능 향상 여부

| Symbolic reasoning | ✅ 향상됨 |

| Logic reasoning | ✅ 향상됨 |

| Mathematical reasoning | ✅ 향상됨 |

| Commonsense reasoning | ✅ 향상됨 |

| Scientific reasoning | ✅ 향상됨 |

특히 주목할 점은,

어느 한 분야만 개선된 것이 아니라 전반적으로 고른 성능 향상이 나타났다는 것입니다.

6. 현업에 적용할 수 있을까? – 기대 효과와 활용 가능성

CODEI/O는 현재 LLM 개발 및 튜닝 작업에 직접 적용하기는 어려울 수 있습니다.

하지만 다음과 같은 측면에서 큰 시사점을 줍니다.

- LLM 성능 한계를 느끼고 있다면, 코드 기반 데이터 활용을 고려해볼 것

- 코드 외에도 논리적 추론을 자극할 수 있는 구조화된 데이터를 적극 활용할 것

특히 LLM 활용 프로젝트에서 복잡한 의사결정, 상태 변화 추론이 필요한 경우,

코드 학습 접근법이 해결책이 될 수 있습니다.

7. CODEI/O가 제시하는 LLM 훈련의 새 방향

LLM 성능 향상을 위한 새로운 접근법인 CODEI/O는

코드를 통해 추론 능력을 길러주는 훈련 방식입니다.

- 코드 입력과 출력을 예측하는 과정에서

모델은 논리적 사고와 문제 해결 능력을 내재화합니다. - 실험 결과, 수학, 논리, 상식 등 다양한 작업에서 일관된 성능 향상이 확인되었습니다.

이제 LLM 성능 향상에서

단순한 데이터 양적 증가를 넘어,

질적으로 논리적 사고를 강화하는 훈련이 중요해지고 있습니다.

CodeI/O: Condensing Reasoning Patterns via Code Input-Output Prediction

CodeI/O is a novel approach that transforms code-based reasoning patterns into natural language formats to enhance Large Language Models' reasoning capabilities. Unlike traditional methods focusing on specific skills, our approach systematically extracts u

codei-o.github.io