AI 모델 학습의 새로운 패러다임: GRPO와 Unsloth로 VRAM 최적화하기

🧠 AI 모델 학습, VRAM 부족 문제 해결할 방법은?

딥러닝 모델을 학습할 때 가장 큰 걸림돌은 무엇일까요? 바로 고성능 GPU와 대량의 VRAM(Video RAM) 요구량입니다. 특히 대규모 언어 모델(LLM, Large Language Model)을 학습하려면 수십에서 수백 기가바이트(GB)의 VRAM이 필요하지만, 대부분의 개발자는 이 정도 사양의 하드웨어를 갖추기 어렵습니다.

그렇다면 적은 VRAM으로도 강력한 AI 모델을 학습할 방법은 없을까요?

💡 해답은 바로 GRPO(Group Relative Policy Optimization)와 Unsloth에 있습니다.

DeepSeek 연구팀이 개발한 GRPO는 강화 학습(RL) 기반의 최적화 알고리즘으로, 모델이 스스로 사고하는 시간을 늘려 학습 효율을 높이는 기법입니다. 그러나 기존 GRPO 구현 방식은 막대한 VRAM을 요구했습니다.

여기서 등장하는 것이 Unsloth입니다. Unsloth는 GRPO를 개선하여 80% 적은 VRAM으로도 학습이 가능하도록 최적화했습니다. 이제 단 7GB VRAM만으로도 GRPO를 활용해 AI 모델을 학습할 수 있습니다.

이 글에서는 GRPO의 원리부터 Unsloth의 최적화 방식, 그리고 실제 적용 사례까지 자세히 알아보겠습니다.

📌 GRPO란 무엇인가? 기존 PPO와의 차이점

🔍 GRPO(Group Relative Policy Optimization)란?

GRPO는 강화 학습(RL, Reinforcement Learning) 기반의 최적화 기법으로, AI 모델이 문제 해결 과정을 스스로 개선하도록 유도하는 알고리즘입니다.

💡 핵심 개념:

- AI 모델이 여러 개의 답변(응답)을 생성합니다.

- 이 답변들에 대해 정해진 기준(보상 함수)에 따라 점수를 부여합니다.

- 각 답변의 점수를 그룹 평균과 비교하여, 높은 점수를 받은 답변을 더 많이 학습하도록 조정합니다.

즉, GRPO는 모델이 여러 답변을 비교하면서 스스로 더 나은 사고 과정(Reasoning Process)을 학습하도록 유도합니다.

🔄 GRPO vs. 기존 PPO(Proximal Policy Optimization)

기존에도 강화 학습을 활용한 최적화 기법인 PPO가 존재했지만, GRPO는 다음과 같은 차이점을 가집니다.

비교 항목 PPO (Proximal Policy Optimization) GRPO (Group Relative Policy Optimization)

| 학습 방식 | 개별 답변에 대한 점수 부여 | 여러 개의 답변을 비교하여 상대적인 학습 진행 |

| 보상 함수 | 절대 점수를 기준으로 평가 | 그룹 내 상대 점수를 기준으로 평가 |

| 추론 과정 | 모델이 주어진 규칙만 따름 | 모델이 스스로 사고 과정을 확장 |

| VRAM 요구량 | 매우 높음 (대량의 데이터 필요) | 상대적으로 낮음 (Unsloth 사용 시 80% 절약) |

👉 즉, GRPO는 AI 모델이 단순한 답변 생성이 아니라, 사고하는 방식을 학습하도록 유도하는 것이 특징입니다.

🚀 Unsloth를 활용한 GRPO 최적화: 최소 VRAM으로 학습하기

🔥 Unsloth란?

Unsloth는 기존 GRPO 알고리즘을 대폭 개선하여, 훨씬 적은 VRAM으로도 고성능 모델을 학습할 수 있도록 설계된 최적화 라이브러리입니다.

✅ Unsloth의 주요 특징

1️⃣ 기존 Hugging Face + FA2 대비 VRAM 사용량 80% 절감

2️⃣ 단 7GB VRAM만으로도 GRPO 학습 가능

3️⃣ QLoRA 및 LoRA와 결합하여 더 효율적인 학습 가능

4️⃣ 대규모 언어 모델(LLM)도 학습 가능 (최대 15B 파라미터 지원)

🛠️ Unsloth + GRPO로 학습하는 방법

다음은 Unsloth를 활용해 GRPO를 적용하는 코드 예제입니다.

1️⃣ Unsloth 설치

pip install unsloth vllm

2️⃣ 모델 불러오기 및 GRPO 적용

from unsloth import FastLanguageModel

# Unsloth를 활용한 모델 로드

model, tokenizer = FastLanguageModel.from_pretrained(

model_name="unsloth/Llama-3.2-3B-Instruct",

fast_inference=True, # 빠른 추론 활성화

)

# 샘플 문장 생성

output = model.fast_generate(["AI 모델 학습이란?"])

print(output)

이렇게 하면 적은 VRAM에서도 빠르고 효율적인 학습이 가능합니다.

📊 GRPO 적용 사례: 실제 성능 향상 실험

Unsloth를 사용한 연구에서는 다음과 같은 성과를 얻었습니다.

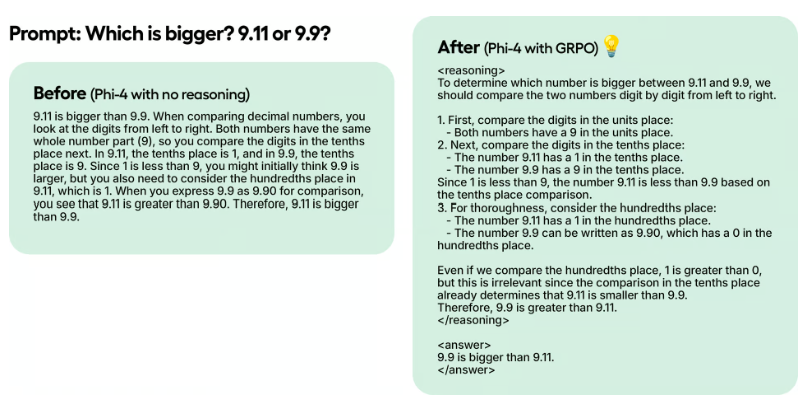

✅ Phi-4 모델(14B)에서 GRPO 적용 결과

- 100 스텝만 학습해도 명확한 개선 효과 확인

- GRPO 적용 모델은 "Thinking Token"을 생성하며 더 나은 답변을 학습

- 동일한 VRAM 환경에서 PPO 대비 더 정확한 결과 도출

💡 즉, 기존보다 적은 학습 데이터와 VRAM으로도 더 강력한 AI 모델을 만들 수 있습니다.

📌 GRPO와 Unsloth가 가져올 AI 모델 학습의 변화

🎯 핵심 요약

✅ GRPO는 AI 모델이 스스로 사고하는 능력을 키우는 강화 학습 기법이다.

✅ 기존 PPO 방식보다 더 적은 데이터로 효율적인 학습이 가능하다.

✅ Unsloth를 사용하면 VRAM 사용량을 80% 절감하면서도 GRPO를 활용할 수 있다.

✅ 단 7GB VRAM으로도 강력한 AI 모델 학습이 가능해진다.

🔮 앞으로 기대되는 점

이제 누구나 고사양 GPU 없이도 AI 모델을 학습할 수 있는 시대가 열렸습니다. Unsloth와 GRPO를 활용하면 소규모 연구자와 스타트업도 대규모 AI 모델을 쉽게 학습하고 활용할 수 있게 될 것입니다.