구글의 차세대 추론 전용 TPU, Ironwood 전격 해부

인공지능 모델이 점점 더 ‘생각하는’ 수준으로 진화하고 있습니다. 더 이상 단순히 데이터를 보여주는 데 그치지 않고, 해석하고 통찰을 제시하는 시대. 바로 Inference(추론)의 시대입니다.

이러한 새로운 패러다임을 위한 인프라가 필요했고, 구글은 그 해답으로 'Ironwood' TPU를 내놓았습니다.

이번 블로그에서는 Google Cloud가 발표한 7세대 TPU, Ironwood가 어떤 기술적 배경을 갖고 있고, 기존 TPU와 무엇이 다른지, 그리고 AI 엔지니어와 개발자에게 왜 중요한지 자세히 알아보겠습니다.

🌐 Ironwood: AI 추론의 시대를 위한 전용 인프라

Ironwood는 구글이 지금까지 개발한 TPU 중 가장 강력하고 효율적인 7세대 칩입니다.

이전 TPU들이 주로 AI 모델 ‘학습’에 집중했다면, Ironwood는 ‘추론(inference)’을 위한 전용 설계라는 점에서 AI 인프라에 큰 변화를 예고합니다.

Ironwood는 거대한 LLM(대형 언어 모델), MoE(전문가 혼합 모델), 그리고 고급 추론을 수행하는 AI 모델의 성능을 최대로 끌어올리기 위해 태어났습니다.

단순히 빠른 속도를 넘어서, 방대한 데이터와 복잡한 연산을 실시간으로 병렬 처리할 수 있도록 설계됐다는 것이 핵심입니다.

⚙️ Ironwood의 핵심 기술: 무엇이 다른가?

Ironwood는 기존 TPU와 비교해 다양한 기술적 도약을 이뤄냈습니다. 하나씩 살펴보죠.

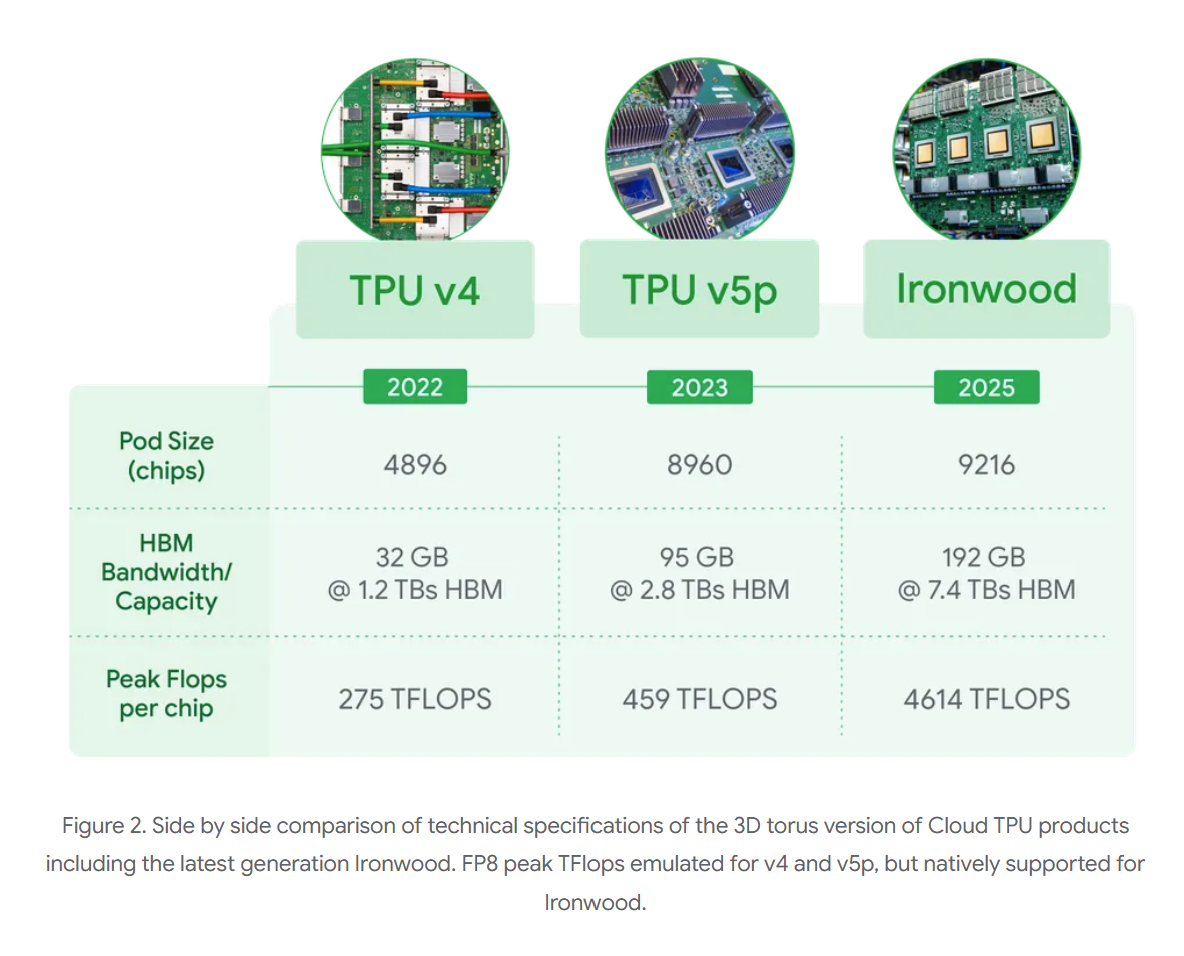

✅ 1. 압도적인 연산 성능

- 1개 칩당 4,614 TFLOPs의 연산 성능

- 최대 9,216개의 칩을 하나의 Pod로 묶으면 42.5 ExaFLOPs, 즉 세계 최대 슈퍼컴퓨터보다도 24배 이상의 성능을 자랑합니다.

이 정도면 단일 AI 모델 학습은 물론, 여러 개의 대규모 추론 작업을 동시에 처리하는 데도 충분합니다.

✅ 2. 전력 효율 개선

- Trillium 대비 2배 높은 성능당 전력 효율

- 액체 냉각 기반 설계로 열 처리 안정성까지 확보

- 2018년 첫 TPU 대비 약 30배 전력 효율 향상

에너지 제약이 점점 심각해지는 AI 환경에서, 효율적인 연산은 선택이 아닌 필수입니다.

✅ 3. 메모리 및 대역폭 향상

- 192GB의 HBM(High Bandwidth Memory), Trillium 대비 6배 증가

- 7.2TB/s의 메모리 대역폭, Trillium 대비 4.5배 증가

- 칩 간 통신 속도 역시 1.2Tbps 양방향, 1.5배 증가

이 덕분에 데이터 이동 최소화, 지연 시간 감소는 물론, 더 크고 복잡한 모델도 매끄럽게 처리할 수 있습니다.

✅ 4. SparseCore 확장 지원

Ironwood는 기존보다 확장된 SparseCore를 내장해,

초대형 임베딩(Embedding)이 필요한 추천 시스템, 금융 모델링, 과학 시뮬레이션 등에도 효과적으로 활용할 수 있습니다.

🤖 Inference 중심 설계: 왜 중요할까?

기존 AI는 ‘입력 → 출력’에 충실한 반응형이었다면, 이제는 AI가 스스로 판단하고 예측하는 ‘사고 중심’ 모델이 요구됩니다.

이러한 LLM, MoE 같은 모델은 단일 칩으로는 감당할 수 없는 수준의 연산 및 메모리 요구량을 가집니다.

Ironwood는 이를 위해 다음과 같은 구조를 갖췄습니다:

- 초고속 칩 간 네트워크(Inter-Chip Interconnect, ICI): 낮은 지연으로 대규모 연산을 병렬 처리

- Pathways ML 런타임: 수십만 개의 TPU를 하나의 클러스터처럼 쉽게 확장 가능

덕분에 수백억 개 파라미터를 가진 AI 모델도 지연 없이 학습과 추론을 수행할 수 있습니다.

🧩 구성 옵션과 활용 사례

Ironwood는 고객의 워크로드에 따라 두 가지 크기 구성을 제공합니다:

- 256개 칩 구성: 중형 모델에 적합한 유연한 구조

- 9,216개 칩 구성: 초대형 모델 학습 및 추론에 최적화된 구조

또한 Google DeepMind에서 개발한 Pathways를 통해,

이러한 구성들을 더 큰 단위로 조합해 수십만 개 TPU까지 확장할 수 있어,

클라우드 환경에서도 손쉽게 슈퍼컴퓨팅 수준의 성능을 구현할 수 있습니다.

✅ Ironwood가 주는 의미: 지금 필요한, 미래형 인프라

Ironwood는 단순히 더 빠르고 큰 TPU가 아닙니다.

‘생각하는 AI’를 위한 진짜 플랫폼, 그리고 새로운 인공지능 시대를 위한 핵심 인프라입니다.

기존보다 성능은 압도적으로 높아지고,

전력과 냉각 효율성은 극대화,

데이터 이동과 지연은 최소화됐습니다.

이러한 혁신을 통해, Ironwood는 다음과 같은 시사점을 남깁니다:

- AI 인프라는 단순 연산 능력을 넘어서, 통합적인 시스템 설계가 핵심이 된다.

- 추론 기반 모델은 앞으로의 AI 경쟁력의 중심이 될 것이며, Ironwood는 그 기반이다.

- 고성능이 곧 고비용이던 시대는 지나가고, 성능 대비 효율이 핵심 지표가 된다.

왜 지금 Ironwood를 주목해야 할까?

지금은 AI의 사고력을 테스트하는 시대입니다.

단순한 응답이 아닌, 통찰과 맥락을 이해하는 인공지능.

그러한 AI가 실현되기 위해서는 ‘Ironwood’ 같은 인프라가 반드시 필요합니다.

“AI의 추론을 진짜로 구현하고 싶다면, 그 첫걸음은 Ironwood입니다.”

https://blog.google/products/google-cloud/ironwood-tpu-age-of-inference/

Ironwood: The first Google TPU for the age of inference

We’re introducing Ironwood, our seventh-generation Tensor Processing Unit (TPU) designed to power the age of generative AI inference.

blog.google