환각을 최소화하는 AI! 컨텍스추얼 AI의 ‘RAG 2.0’과 GLM의 혁신

🏆 AI의 사실 정확도를 한 단계 높이다!

인공지능(AI)의 가장 큰 문제 중 하나는 ‘환각(hallucination)’, 즉 잘못된 정보를 사실처럼 생성하는 현상입니다. 이를 해결하기 위해 **컨텍스추얼 AI(Contextual AI)**가 새로운 검색 증강 생성(RAG) 기술을 기반으로 한 **‘RAG 2.0’**을 발표했습니다.

이 기술을 적용한 **GLM(Grounded Language Model)**은 명확한 근거를 바탕으로 AI가 응답을 생성하도록 설계되었습니다. 흥미롭게도, 이 모델은 구글, 앤트로픽, 오픈AI 등의 최신 대형언어모델(LLM)보다 뛰어난 사실 정확도를 기록했습니다.

이번 블로그에서는 RAG 2.0 기술이 기존 RAG의 한계를 어떻게 극복했는지, 그리고 GLM이 어떤 방식으로 정확도를 극대화했는지 살펴보겠습니다.

📌 RAG란 무엇인가? 기존 한계점은?

🔹 RAG (검색 증강 생성)란?

RAG는 Retrieval-Augmented Generation의 약자로, AI가 응답을 생성할 때 외부 데이터베이스에서 검색한 정보를 참고하여 보다 정확한 답변을 제공하는 기술입니다.

🔹 기존 RAG의 한계

하지만 기존 RAG 모델은 여러 요소가 조합된 형태라 최적화되지 못한 경우가 많았습니다.

- 검색 데이터베이스와 AI 모델이 별도로 작동하며, 이를 연결해야 하는 구조

- 원하는 결과를 얻기 위해 복잡한 프롬프팅이 필요

- 한 요소의 오류가 전체 시스템에 영향을 미치는 문제

컨텍스추얼 AI의 CEO 도우웨 키엘라는 이를 **"프랑켄슈타인의 괴물"**에 비유하며 기존 RAG 시스템의 불완전성을 지적했습니다.

🚀 RAG 2.0의 혁신: 기존 한계를 어떻게 극복했나?

🔹 통합된 최적화 시스템

RAG 2.0은 기존과 달리 검색과 언어 모델을 하나의 통합 시스템으로 구성하여 최적화했습니다.

- AI가 검색과 생성 단계를 동시에 학습하여 성능 향상

- 정보 검색 및 처리가 동일한 시스템 내에서 이루어짐

🔹 ‘혼합 검색기(Mixture-of-Retrievers)’ 도입

- 질문을 받으면 가장 적절한 검색 방법을 자동으로 계획

- 최신 AI 모델처럼 논리적 사고를 활용한 검색 최적화

🔹 고성능 ‘재 순위 모델(Re-ranker)’ 적용

- 검색된 정보 중 가장 중요한 내용을 선별

- 정확도를 극대화한 후 GLM에 전달

🔥 GLM: 가장 사실적인 AI 모델로 등극

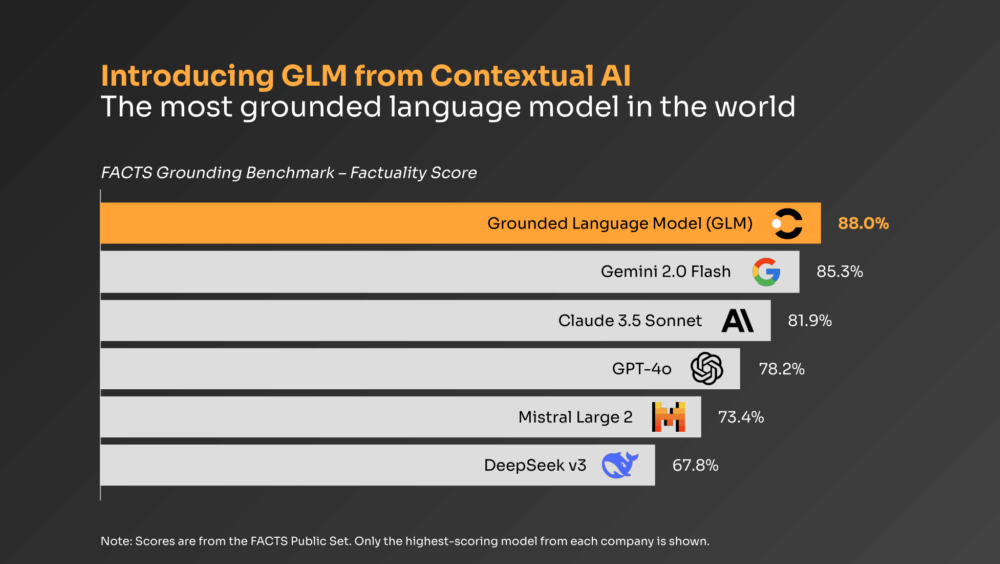

컨텍스추얼 AI의 GLM은 사실 검증 벤치마크 **‘FACTS’**에서 경쟁 모델들을 능가하는 성능을 보였습니다.

📊 FACTS 벤치마크 점수

✅ GLM – 88%

✅ 구글 ‘제미나이 2.0 플래시’ – 84.6%

✅ 앤트로픽 ‘클로드 3.5 소네트’ – 79.4%

✅ 오픈AI ‘GPT-4o’ – 78.8%

GLM은 사실 기반 응답 생성에 있어 현존하는 모든 AI 모델을 뛰어넘는 결과를 기록했습니다.

🎯 GLM은 어떻게 사용할 수 있을까?

현재 컨텍스추얼 AI에서는 무료 API 크레딧을 제공하고 있어, 계정을 생성하면 GLM을 직접 테스트해볼 수 있습니다.

1️⃣ 컨텍스추얼 AI 웹사이트에서 계정 생성

2️⃣ API 키 발급

3️⃣ AI 챗봇 또는 검색 시스템과 연동하여 사용

🏁 AI의 새로운 기준을 세우다

컨텍스추얼 AI의 RAG 2.0과 GLM은 기존 AI 모델들이 가진 환각 문제를 해결하며, 사실 정확도가 가장 높은 AI 모델로 자리 잡았습니다.

✅ 최적화된 통합 시스템으로 기존 RAG 한계를 극복

✅ 혼합 검색기와 재 순위 모델을 적용해 검색 정확도 향상

✅ FACTS 벤치마크에서 구글, 오픈AI를 뛰어넘는 성능 기록

AI의 신뢰성이 중요한 시대, 컨텍스추얼 AI의 GLM은 가장 사실적인 AI 솔루션으로 주목받고 있습니다. ✨